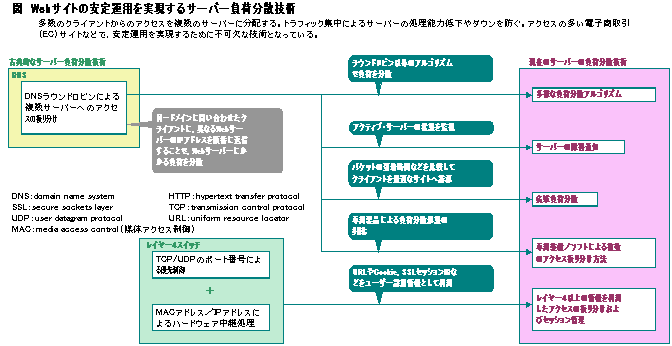

�����С����ʬ������

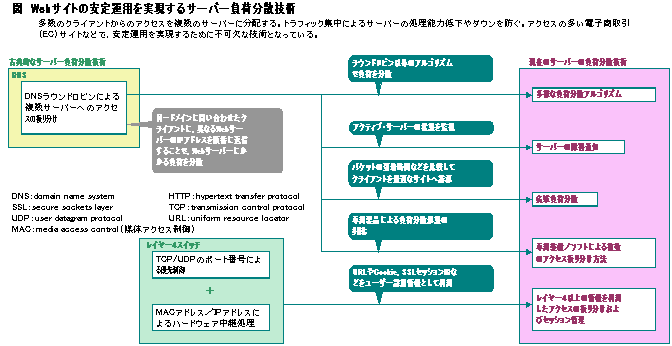

����Web�����С���URL�ʤɡ��桼������������������Ȥ��˻Ȥ���������Ѥ����ˡ�ʣ�������С��˽�����ʬ��������ס����줬�������С����ʬ�����Ѥ���Ū����

�������С����ʬ�����Ѥϡ����饤����Ȥ���Υ���������ʣ����Υ����С��˿���ʬ���ƽ�����ʬ�����롣�ºݤ����ʬ������ˡ�ϡ�DNS���䤤��碌�����饤����Ȥ��Ф��ơ��ۤʤ�Web�����С���IP���ɥ쥹������������ˡ�䡤�������ʤ����Ѥ��ƥ����������͡�����ˡ��ʬ�ۤ�����ˡ�ʤɤ����롣������⡤����Υ����С��Ǥϸ³����������ǽ�Ϥ�ʣ����Υ����С���ʬô���뤳�Ȥǡ�������ǽ����夵����Τ���������

�ޡ�Web�����Ȥΰ��걿�Ѥ�¸����륵���С����ʬ������

�������С����ʬ�����Ѥϡ��ŻҾ������EC�ˤ���Ƭ�ǰ������ܤ��EC�����ȤĤ�����ȼԤˤȤäƤϡ�����ե�Ȥʤ�Web�����С��ʤɤΥ����ƥब�����������뤳�Ȥϵ�����ʤ������������㲼�Ϥ��Τޤ��פ˶����������

��Web�����С������ʬ���ξ�硤��1��Υ����С���������HTTP�ꥯ�����Ȥ�Ʊ����������300�˶�Ť����鸡Ƥ����桼������¿���ס��ǡ������̤��礭�����ȥ�ࡦ�ǡ����ʤɤ����Ϥ�����⤵��˾��ʤ��ꥯ�����ȿ��Ǥ����ʬ����ɬ�פˤʤ롣

��������ǽ�θ����Τۤ��ˤ⡤�����С����ʬ�����Ѥ���ĤΥ��åȤ�⤿�餹����Ĥϡ��Ѿ㳲�������������ȡ��⤦��Ĥϡ������С��γ�ĥ���ưפˤʤ����Ȥ�������Υ����С��������Ƥ⡤�Ĥ�Υ����С�������������Ѥ����Ȥ��Ѿ㳲���ϸ��夹�롣�����Ȥ��Τ�Τ�ߤ᤺�ˡ������С����ڤ�Υ�������ƥʥ��ưפ���

������ˡ������Ȥα��Ѥ�Ϥ��⡤�����ӥ���ߤ᤺�˷�³Ū�˥����С������ߤ��뤳�Ȥdz�ĥ��������롣�����ȳ������餽��ۤɤΥ�����������ʤ��Ƥ⡤���饤����Ȥ����äȶ��˥����С������ߤ�����ɤ������Τ��ᡤ��¿���Υ����Ȥ�����������γ�ĥ�ۤ���ʣ�������С��DZ��Ѥ����ס�

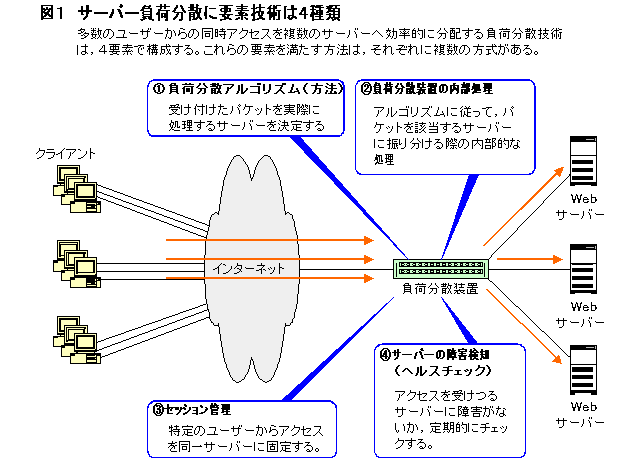

�������С����ʬ�����Ѥϡ����ɤΥ����С�������������������뤫����륢�르�ꥺ�������ºݤ˥ѥ��åȤ�ʬ������ˡ�������ץꥱ�������٥�ǥ���������Ʊ�쥵���С��˸��ꤹ�뤿��Υ��å����������������С��ξ㳲�����Σ�����ε��Ѥǹ�������ʿޣ��ˡ�

�ޣ��������С����ʬ�������ǵ��Ѥϣ�����

�����Υ����С����ꥢ�르�ꥺ��ϡ����饤����Ȥ��������ä��ǡ������ѥ��åȤ�ɤΥ����С����ºݤ˽������뤫��������������С����˻�����ͥ���̤����ꤷ�ƽ��֤˥���������ʬ������ˡ�䡤�����С�Ʊ�Τ���پ����ʤɤξ����ꥢ�륿����˸��ʤ�����������С�����ꤹ����ˡ�ʤɤ����롣

������������Υ����С������ꤷ���顤���ˤ�ꡤ�������륵���С��إѥ��åȤ�ʬ���������ʬ���η��֤ˤ�ꡤ�ºݤ˽������륵���С��ظ������͡�����ˡ�ǥѥ��åȤ����롣

��ʣ���Υ����С��ǽ�����ʬ����������ǡ�Ʊ�����饤����Ȥ���Υ���������տ�Ū��Ʊ�쥵���С��˸��ꤷ������礬���롣���λ���ɬ�פȤʤ�Τ������Υ��å������������äˡ�EC�����Ȥǥ��饤����Ⱦ�������������ʤɤ��Բķ硣�����С��β�Ư������ƻ뤹�뭤�ε����⡤�����С����ʬ�����Ѥˤ�ɬ�פ����ǤȤʤ롣

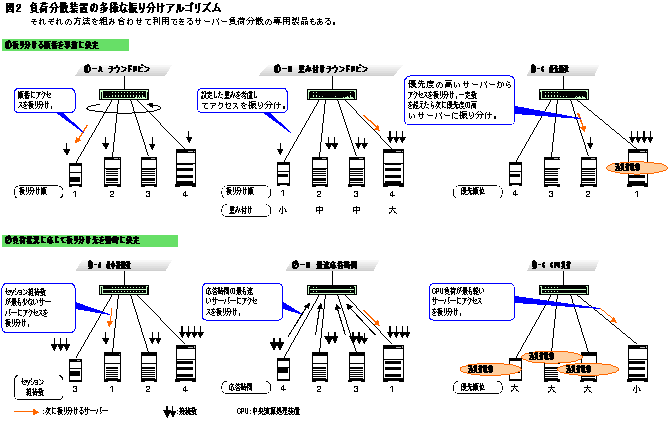

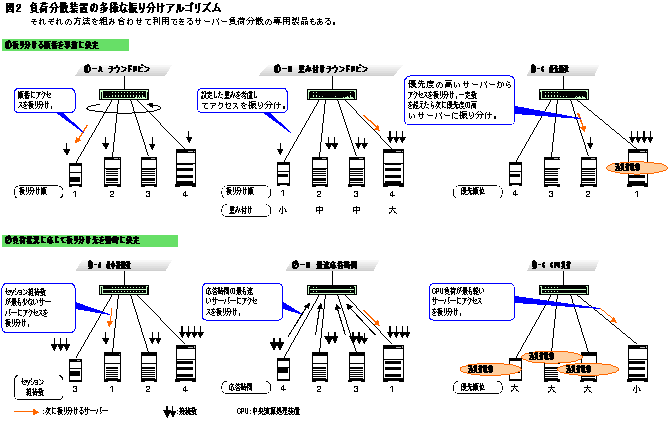

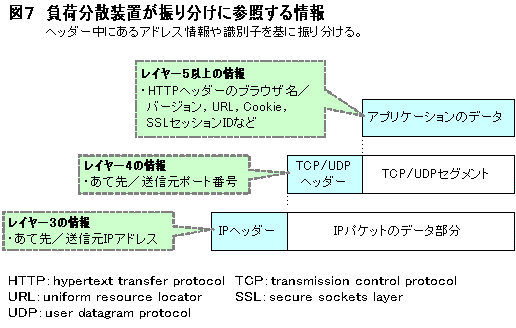

�����饤����Ȥ���Υ����������Ф��ơ������С����ʬ�����Ѥ��ޤ�Ƚ�Ǥ���Τϡ��֥���������ɤΥ����С��˿���ʬ���뤫�פȤ���������Ŭ�ʥ����С�����ꤹ��ˤϡ��͡��ʾ���Ȥ��롣����Ū�ˤϡ������饦��ɥ��ӥ������Ť��դ��饦��ɥ��ӥ�����ͥ���������Ǿ���³��������®������������CPU����Ȥ��ä����르�ꥺ�ब��ɽŪ�Ǥ���ʿޣ��ˡ�

�ޣ������ʬ�����֤�¿�ͤʿ���ʬ�����르�ꥺ��

�����Τ������Ǥ����Ū���������饦��ɥ��ӥ�������饤����Ȥ���������������������ʬ�����륵���С����˽��֤˽�����ʬ���롢�ʿޣ��έ��ݣ��ˡ��ֿ���ʬ����Web�����С��ν�����ǽ�˰㤤���ʤ����ϡ��饦��ɥ��ӥ�����ʬ�������礬¿���ס�

��������������ĸġ��Υ����С�����ǽ���ۤʤ���ϡ��Ť��դ��Ǻ���Ĵ������ʿޣ��έ��ݣ¡ˡ�������ǽ�ι⤤�����С��ˤ�¾���⥢��������¿������ʬ����褦�����ꤹ�롣���������ϡ��ֽ���ǽ�Ϥΰ㤦�����С������ʬ����������ä˸���Ū�ס�

������ǽ�Ϥκ���Ĵ���������Ǥϡ�ͥ����������ͭ���Ǥ��롣����Ū�ˤϡ��ƥ����С���ͥ���̤���Ƥ���������Υ����������������Ƥ��鼡��ͥ���̤Υ����С��˽�����ʬ����ʿޣ��έ��ݣáˡ�

���饦��ɥ��ӥŤ��դ���ͥ���̤Σ������ϡ�����ʬ����Υ����С�����پ����˴ط��ʤ������������ꤷ�����֤ǥ���������ʬ���롣����С���Ū�ɤ���ˡ�������ˤϡ�������٤νŤ������С���³���ƥ�����������꿶���뤳�Ȥ⤢�롣

�������ǡ��ġ��Υ����С��ξ��������Ū�˴ƻ뤷�ơ��������ٺ�Ŭ�ʥ����С��˽������ưŪ�ɤ˿���ʬ����Τ����Ǿ���³������®�������֡�CPU��٤Σ��������ˡ����

���Ǿ���³���ϡ����饤����ȤȤδ֤�ĥ�ä����å��������Ǥ⾯�ʤ������С���������ˡ�ʿޣ��έ��ݣ��ˡ������������å�������Ʊ���Ǥ⡤�ºݤˤ���ꤹ��ǡ����̤��㤦���⤢�롣���Ѥ����ʬ�����֤�¬���ѥѥ��åȤ����������������֤���û�Υ����С��˽�����ʬ������ˡ�ʤ顤�����������Τ��İ��Ǥ���ʿޣ��έ��ݣ¡ˡ�

��CPU����پ�����ƻ뤷�ơ���٤��㤤�����С��ؽ�����ʬ�ۤ�����ˡ�⤢��ʿޣ��έ��ݣáˡ����������ºݤ�CPU�ν�����٤����Ǥϥ����С�����پ��������ˤ��İ��Ǥ��ʤ������Τ��ᡤ��¾���������Ȥ߹�碌�����Ѥ��륱������¿���ס�

�������Υ��르�ꥺ��ʳ��ˤ⡤������IP���ɥ쥹��TCP/UDP�Υݡ����ֹ����ꤷ�ơ�����ʬ���륵���С�����Ƥ�����ˡ�⤢�롣������ˡ��Ȥ��ȡ�����δ�Ȥ䥤���ͥå���³���ȼԡʥץ��Х����ˤΥ桼��������Υ���������Ʊ��Υ����С��˿���ʬ�����ꡤWeb����������FTP���̤Υ����С��ǽ���������ʤɤ�����ǽ�ˤʤ롣

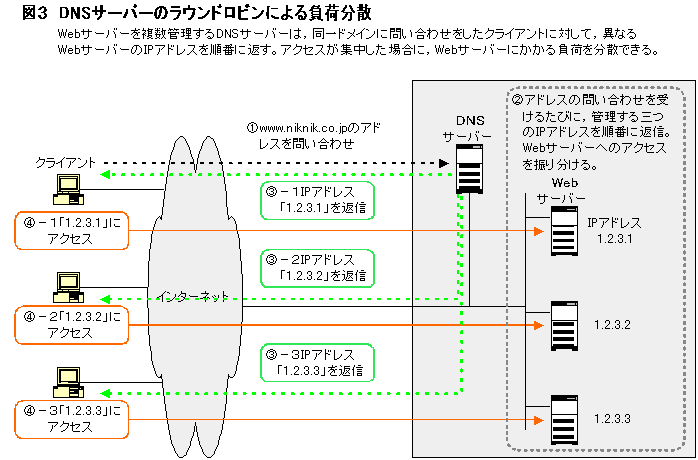

�����饤����ȤΥ�������������������ĥ����С������ꤷ���顤���ϼºݤ˳������륵���С��˽�����ʬ���롣������ˡ�ˤϡ�DNS��Ȥ��������ȡ��������ʤ�Ȥ����Σ��̤꤬���������Ǥ����������Ѥ���Ƥ���Τ���DNS��Ȥä����Ȥߤ���

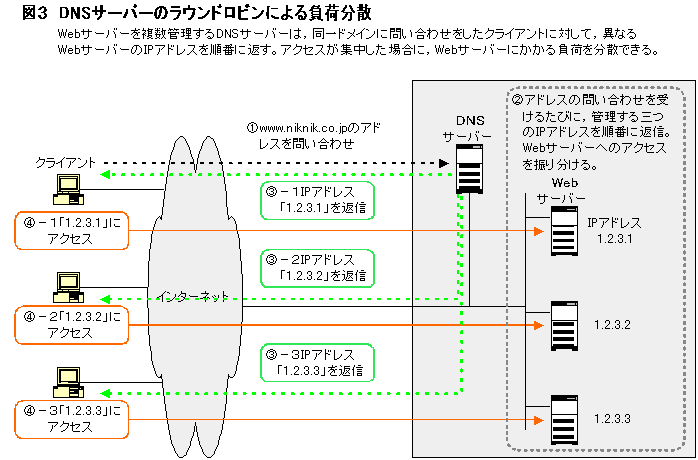

��DNS��Ȥ���ˡ�Ǥϡ��������������Web�����С��˸��̤�IP���ɥ쥹�������ƤƤ��������ɥ쥹���䤤��碌�����뤿�Ӥ˰ۤʤ�IP���ɥ쥹����֤��֤��ʿޣ��ˡ�

�ޣ���DNS�����С��Υ饦��ɥ��ӥ�ˤ�����ʬ��

IP���ɥ쥹���ֿ����륢�르�ꥺ��ˤϡ��饦��ɥ��ӥ������ࡦ�饦��ɥ��ӥ�ʤɤ����������롣DNS�����С������饤����Ȥ�缡�㤦�����С���ͶƳ���뤳�Ȥǡ�������ʬ���Ǥ��롣

��DNS��Ȥä����ʬ���ϡ�DNS��������������Ū��ñ�����ѤǤ��롣����ˡ����Ѥ����ʬ�����֤��Ȥ߹�碌�뤳�Ȥǡ��ϰ�Ū��Υ�줿ʣ���Υ����Ȥ�Ϣ�Ȥ��������٤����ʬ����¸����뤳�Ȥ��ǽ�Ǥ�����̷ǵ����ȡˡ�

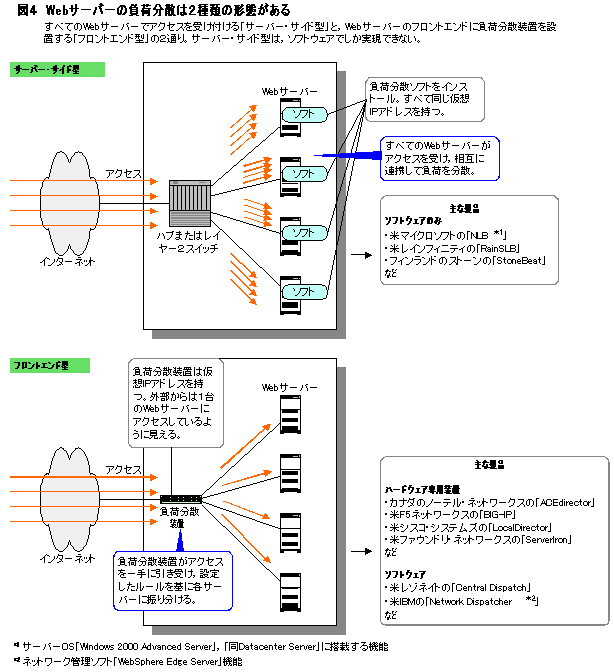

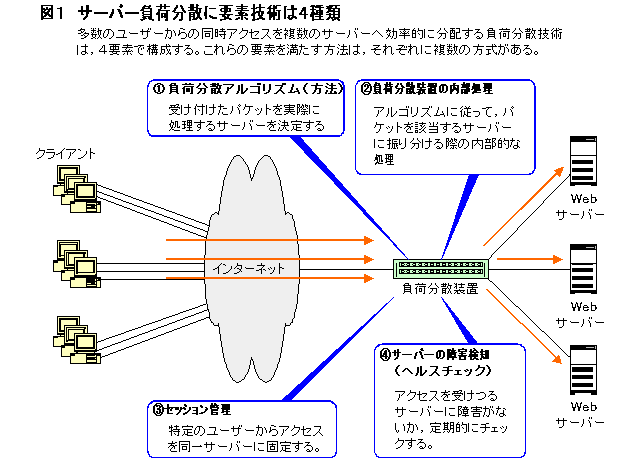

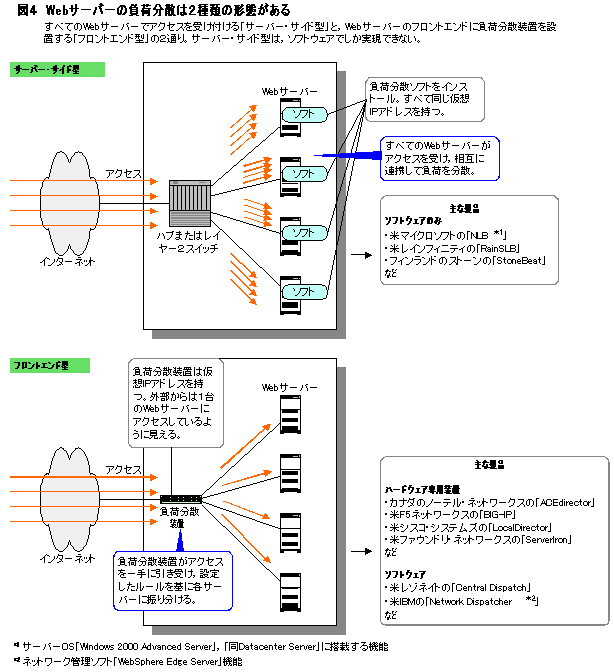

�������������С����ʬ�����������ʤξ�硤����������������륵���С��˥ѥ��åȤ�ʬ������֤ϣ����ढ�롣���饤����Ȥ���Υ���������٤ƤΥ����С���������������С��������ɷ��פȡ������С������������֤������ʬ�����֤�����������ʬ������ե���ȥ���ɷ��פ��ʿޣ��ˡ�

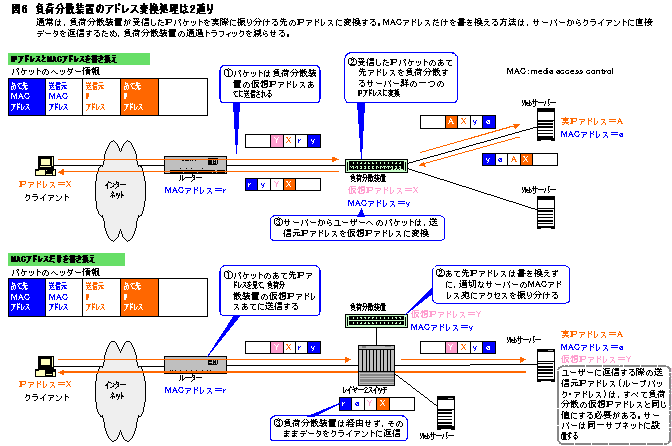

�ޣ���Web�����С������ʬ���ϣ�����η��֤�����

���ե���ȥ���ɷ������ʬ�����֤ϡ��������ʤ������դ������饤����ȤΥ���������Web�����С��˸�ΨŪ�˿���ʬ���롣�������ʤϡ����ʬ���Υ��르�ꥺ��˴�Ť�������Υ����С��˽��������椷�ʤ��褦�˥Х���롣��ˤϡ�Web�����С��˥��եȤ����������پ��������Ū�����Τ���������������ʬ�ۤ������ʤ⤢�롣

�������Υ����С��������ɷ������ʬ�����ʤϤ��٤ơ����ʬ�������Ѥ��륵���С������ѥ��եȤȡ��뤹����֡����Υ��եȤ����Ƽ異�르�ꥺ���Ȥäƽ������륵���С�����ꤷ�����Υ����С��ȥ��饤����Ȥδ֤��̿���¹Ԥ���ʿޣ��ξ�ˡ�

�������С��������ɷ������ʬ���ϡ�����Ƴ���κݤ˸����Υͥåȥ���������ä��ѹ�����ɬ�פϤʤ������Τ������ŪƳ�����ưפǤ��롣

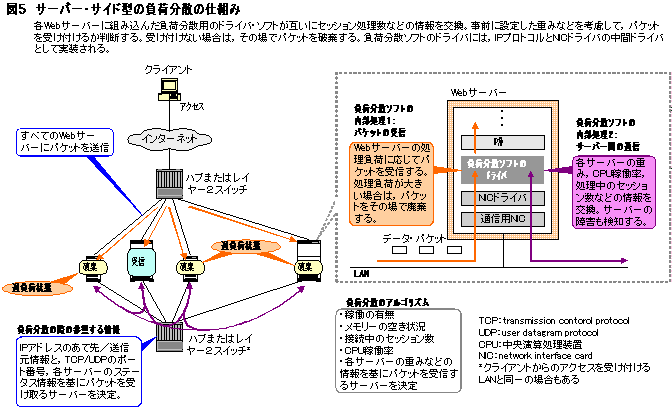

�������С��������ɷ������ʬ���μ¸���ˡ�ˤĤ��ơ��ܤ������Ƥߤ褦��

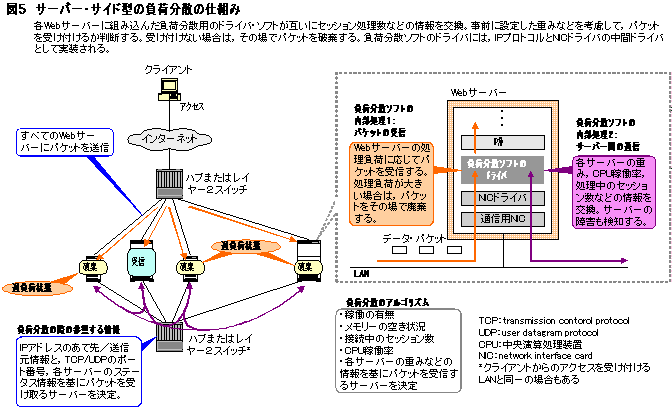

����������������������С������ºݤ˥ѥ��åȤ�������뤫�ɤ����ϡ��쥤�䡼���ȥ쥤�䡼���δ֤˥��ȡ��뤷�����ʬ�����եȤ����ѥɥ饤�Ф�Ƚ�Ǥ���ʿޣ��ˡ�

�ޣ��������С��������ɷ������ʬ���λ��Ȥ�

���ƥ����С��˥��ȡ��뤷���ɥ饤�Фϡ����ѤΥץ��ȥ����Ȥäơ����Ū�˸ߤ���CPU��ƯΨ�������Υ��å������ʤɤξ�������ꤷ���ݻ����롣������������ƥ����С��β�Ư��������١��ѥ��åȤ������륵���С�����롣������IP���ɥ쥹��TCP/UDP�Υݡ����ֹ���˽�����ô�����륵���С������ꤹ�뤳�Ȥ�Ǥ��롣�ѥ��åȤ������륵���С������ꤷ�������ǡ��ۤ��Υ����С��ϥѥ��åȤ��˴����롣

�������С��������ɷ������ʬ������ħ�ϡ����٤ƤΥ����С�����������������դ�������Windows2000�Υ����С����ʤ˥����С��������ɷ������ʬ����ǽ����������ޥ��������եȤϡ��֣�����ǥ�������������ƥѥ��åȤ�ž������ե���ȥ���ɷ�����٤ơ����̤Υ����С������פʥѥ��åȤ�ե��륯�����Τǽ�����®�����ܥȥ�ͥå���ȯ�����ˤ����סˤȤ�����

�������С��������ɷ��ϡ����٤ƤΥ����С������饤����Ȥ���Υǡ������ѥ��åȤ�������ɬ�פ����롣���Τ��ᡤ�ġ��Υ����С��ˤϡ������褬���̤β���IP���ɥ쥹�������Ƥ롣�쥤�䡼����MAC�ءˤǤ⡤������ä��������ͥåȡ��ե졼��٤ƤΥ����С��˥֥����ɥ��㥹�ȡ�Ʊ��ˤ���ɬ�פ����뤿�ᡤ�����С����Υե���ȥ���ɤˤϡ��ϥ֤��쥤�䡼�����å������֤��롣

���쥤�䡼�������å��ξ��ϡ������С����饯�饤����Ȥ���������ѥ��åȤ�������MAC���ɥ쥹��ޥ�������ʤɤ��ơ������å��Υ��ɥ쥹�ؽ���ǽ����ߤ�����ɬ�פ����롣�������뤳�Ȥǡ������å���MAC���ɥ쥹��LAN�ݡ��Ȥ��б��դ��뤳�Ȥ��ɤ������٤ƤΥ����С��˥ѥ��åȤ�֥����ɥ��㥹�Ȥ��롣

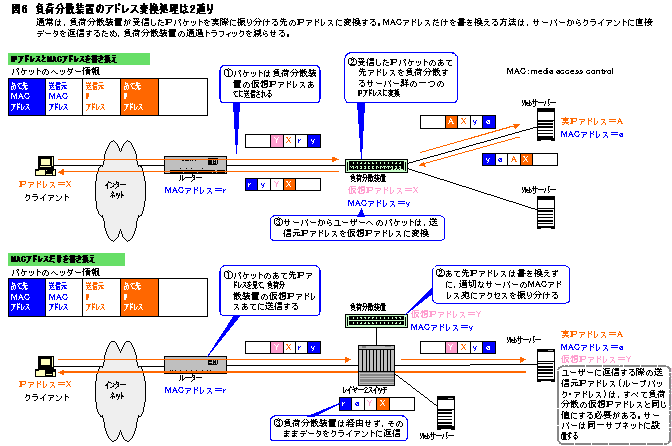

���������ʤ����˼���������������ʬ����ե���ȥ���ɷ��ϡ�����IP���ɥ쥹�Ǽ������ѥ��åȤΥ��ɥ쥹����ºݤ˽������륵���С��Υ��ɥ쥹�˽���������Ф���

�ޣ������ʬ�����֤Υ��ɥ쥹�Ѵ������ϣ��̤�

���������ɥ쥹�Ѵ������ˤϡ�IP���ɥ쥹��MAC���ɥ쥹���������ˡ�ȡ�MAC���ɥ쥹�������������ˡ�Σ��̤꤬������

IP���ɥ쥹��MAC���ɥ쥹�ν��������ϰʲ��Τ褦�ˤʤ�ʿޣ��ξ�ˡ����饤����Ȥ����������ǡ������ѥ��åȤϡ����ʬ�����֤˽��ޤ롣���ʬ�����֤ϸġ���IP�ѥ��åȤΤ�����IP���ɥ쥹�ºݤ�ʬ�ۤ��륵���С��μ�IP���ɥ쥹���Ѵ����롣ȿ�Фˡ������С�¦����Υѥ��åȤˤĤ��Ƥ�������IP���ɥ쥹�����ʬ��������Dz���IP���ɥ쥹���Ѵ����롣

�������Ѵ������ˤ�ꡤ���饤����Ȥ�������륵���Ȥ�IP���ɥ쥹�ϰ�ĤǺѤࡣ���饤����Ȥ���ϡ��������Ⲿ��IP���ɥ쥹�Υ����С�������̿����Ƥ���褦�˸�������Ȥߤ���

���������������Ѵ�������ˡ�����硤���饤����Ȥȥ����С����������ѥ��åȤϡ�ɬ�����ʬ�����֤��ͳ���롣�����ȥ�ࡦ�ǡ����ʤɤ������̤Υե����������������䡤Ʊ�����������������ʾ��¿�����ϡ����ʬ�����ּ��Ȥ��ܥȥ�ͥå��Ȥʤ�������ǽ���⤢���ס�

�����Τ��ᡤ���饤����Ȥ���Web�����С��˥�������������ˤ������ʬ�����֤��Ѵ������ơ������С����饯�饤����Ȥؤ�ľ�ܥǡ�����������ˡ�⤢�롣MAC���ɥ쥹�������������ˡ�Ǥ��롣

������Ū�ˤϡ����Τ褦����ˡ�Ǽ¸����롣���ʬ�����֤ϡ����饤����Ȥ��������IP�ѥ��åȤΥ��ɥ쥹����ˤ��ѹ���ä����ˡ��������ͥåȥե졼��Τ�����MAC���ɥ쥹������Web�����С��Τ�Τ��դ��ؤ��롣�������뤳�Ȥǡ������С����饯�饤����ȥؤα����ϡ����ʬ�����֤��ͳ�����˺Ѥ�ʿޣ��β��ˡ�

��������ˡ�Ǥϥ����С����饯�饤����ȥ�ľ�ܥǡ������������뤿�ᡤ��������IP���ɥ쥹�����饤�����¦�˻Ĥ롣Web�����С��ġ��Υ��ɥ쥹�����ΤޤĤäƤ��ޤ��ȡ�����ʹߤϥ��饤����Ȥ��ġ���Web�����С����Ƥ˥�����������褦�ˤʤꡤ���ʬ�������ޤ���ǽ���ʤ��ʤ롣

�����Τ��ᡤ�ƥ����ЭϤˤϡ���IP���ɥ쥹�Ȥ��̤ˡ����ʬ�����֤β���IP���ɥ쥹��롼�ץХå������ɥ쥹�Ȥ������ꤷ�Ƥ������������뤳�Ȥǡ�Web�����С������饤����Ȥ��ֿ��������������ɥ쥹�ϡ����ʬ�����֤β���IP���ɥ쥹�ˤʤꡤ�ƥ����С��μ�IP���ɥ쥹�����饤����Ȥ��ݻ������Ȥ�����������Ǥ��롣

���ޤ���MAC���ɥ쥹����������뤿�ᡤ���ʬ�����륵���С�����Ʊ�����֥ͥåȤˤĤʤ�ɬ�פ����롣

�������С����ʬ�����Ѥ�Ȥ��С����饤����Ȥ���Υ��������ϡ����ʬ�����ʤ����ꤷ�����르�ꥺ��˴�Ť���ʣ���Υ����С��˸�ΨŪ�˿���ʬ�����롣

����������TCP�ΰ�Ϣ�ν����Ǥϡ��ǡ�����ʣ����IP�ѥ��åȤ�ʬ�䤵��Ƥ��륱����������Ū���Ĥޤꡤ��Ĥ�TCP���å������Υǡ�������ʣ���Υѥ��åȤ�ʬ�䤵��ƥ����С�����������Ƥ��롣ʬ�䤵�줿�ѥ��åȤϡ������դ��륵���С���Ʊ���Ǥʤ����TCP�������³�Ǥ��ʤ���

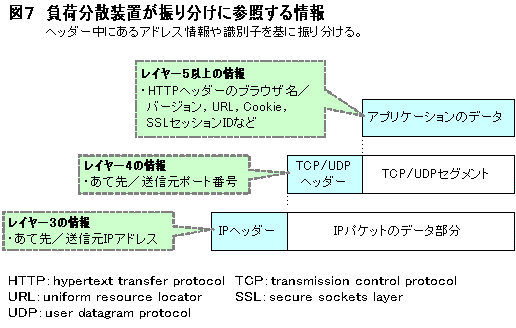

�����Τ��ᡤ�ե���ȥ���ɷ������ʬ�����֤ϥǡ������ѥ��åȤ�IP�إå�����TCP/UDP�إå���������Ȥ߹�碌�ơ�����ʬ����Υ����С����̤���ʿޣ��ˡ�

�ޣ������ʬ�����֤�����ʬ���˻��Ȥ������

������ˡ���Ĥ�TCP���å������Υǡ����Τ��������ꤹ������Ǥʤ���TCP���å���������Ǥ��줿��⡤�Ƥ�Ʊ�������С�����³������Ȥߤ����������ʬ�����ʤ⤢�롣���ε�ǽ�����å���������ǽ�Ǥ��롣

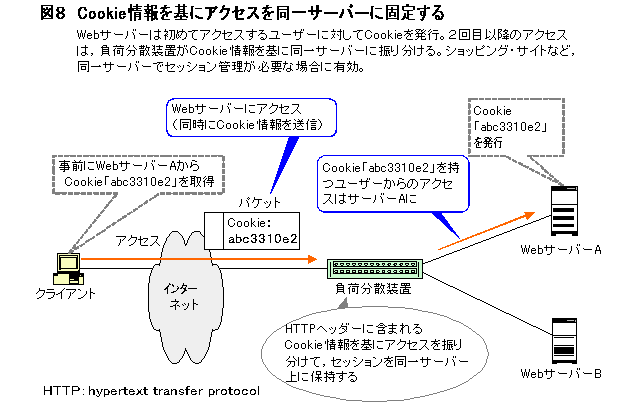

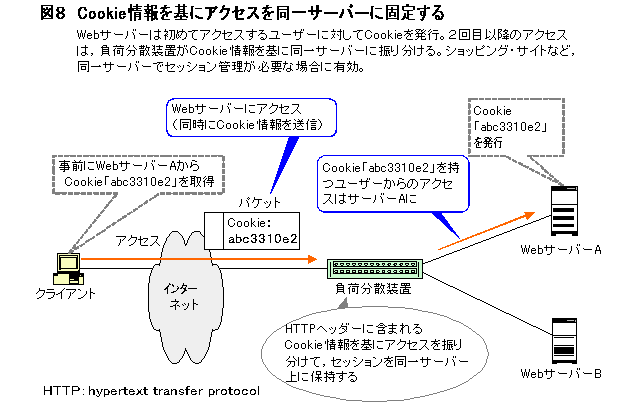

���ä�EC�����Ȥʤɤǡ����륯�饤����Ȥ�����̿���Ʊ�쥵���С��˸��ꤹ����˻Ȥ�������åԥ������ȵ�ǽ�Ǥϡ����饤����Ȥ�ʣ���Υڡ����ˤޤ����ä��㤤ʪ�Ƥ�������ǡ��̤Υ����С��˽�����ʬ���Ƥ��ޤ��ȡ��桼�����Υ��ơ�������̷�⤬�Ф��ǽ�������뤫�����

�����å��������ϡ����ʬ�����֤���̥쥤�䡼�ξ���Ȥ��ơ����ܰ����դ��Ƥ��������Ǥ��줿��ϺƤӤ����ܰ��Ȥ���Ʊ�쥵���С��˸��ꤹ�뤳�ȤǼ¸����롣

���ܰ��Ȥ��������̾��������IP���ɥ쥹��Ȥ���Ʊ��������IP���ɥ쥹��Ʊ�쥵���С��˿���ʬ����С����å����ϸ���Ǥ��롣���������ץ������ƥ����С���Ȥ���Ȥ���Υ��������ʤɡ�Ʊ��������IP���ɥ쥹����¿���Υ������������ȡ��������륵���С����ФäƤ��ޤ������ʬ�������ޤ���ǽ���ʤ���

�����Τ��ᡤ���ߤϡ�Web�����С����饯�饤����Ȥ˲��餫�μ��̾����Ϳ���Ƴ�ǧ��������������Ū�סˤ�����ɽŪ�ʼ��̾���SSL���å����ID��Cookie�ʿޣ��ˡ�

�ޣ���Cookie������˥���������Ʊ�쥵���С��˸��ꤹ��

��������SSL���å����ID�ξ�硤Web�֥饦���ˤ�äƤ����Ū��ID������뤿�ᡤ�̾��EC�����ȤǤϡ֥��å��������ˤ�Cookie�����Ѥ��륱������¿���ס�

����������Cooke�����Ѥ���ݤ⡤SSL�ǥǡ������Ź沽����Ƥ���ȡ����̤ˤ����ѤǤ��ʤ������ξ��ϡ�������SSL�ǡ�����������ơ��Ź沽���줿Cookie���ɤ�뵡ǽ����ĥ����С����ʬ�����֤�ɬ�פˤʤ롣

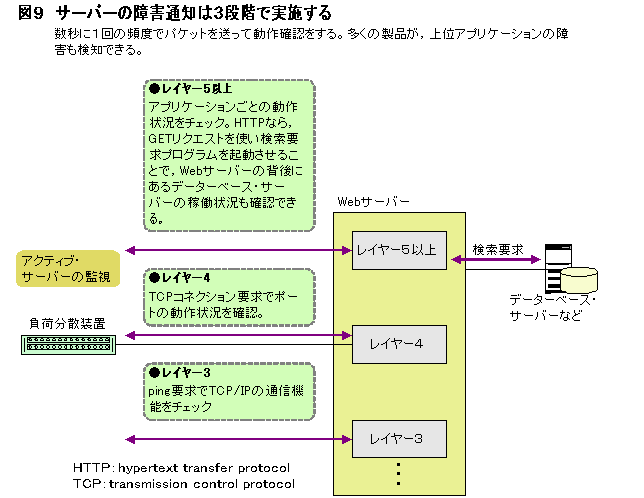

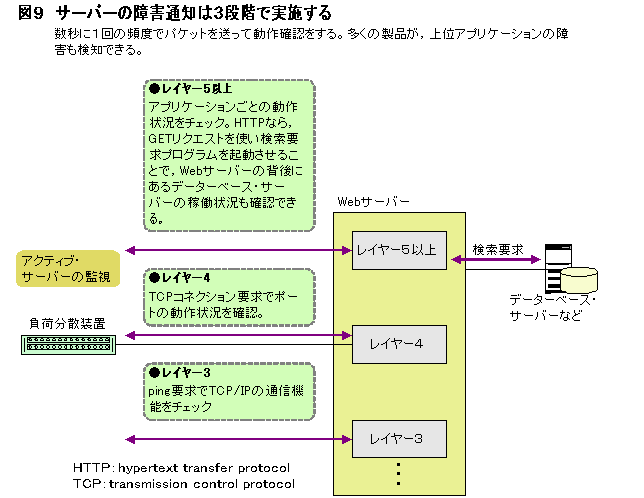

�����ʬ�����֤ϥ��å��������Τۤ��ˡ������С��ξ��֤�ƻ뤹��֤إ륹�������å���ǽ�������롣��Ư�������˥����å����ơ�����ʬ����ǽ�ʥ����С���۾��ȯ�����İ�����ʿޣ��ˡ�

�ޣ��������С��ξ㳲���Τϣ��ʳ��Ǽ»ܤ���

���إ륹�������å���ǽ�ϡ�¿�������ʤ����ʳ��Υ�٥�Ǽ»ܤ��롣�Ǥ�¿���Τ����쥤�䡼���Ǽ¸�����ping���ޥ�ɤ�Ȥä���Ư�����Υ����å�������������ping���Ф���쥹�ܥ����Ǥ�TCP/IP���̿���ǽ������˵�ǽ���Ƥ��뤫�ɤ����ޤǤ���ʬ����ʤ�������ؤΥ��ץꥱ�������β�Ư������Ĵ�٤뤿��ˡ����ʬ�����֤�������쥤�䡼����٥��TCP���ͥ���������Ф����ݡ���ñ�̤Ǽºݤ˥��ͥ������ĥ��뤫�ɤ����ޤǥ����å��������ʤ�¿����

������ˤ�ꡤ�㤨�Хݡ����ֹ�80��HTTP�����ӥ��ȡ��ݡ����ֹ�20/21��Ȥ�FTP�����ӥ��ʤɤξ�������̤˥����å��Ǥ��롣���ݡ��Ȥ��Ȥ˺٤��������å����뤳�Ȥǡ�������Τ˿���ʬ����ǽ�ʥ����С��ξ������İ�������ΨŪ�����ʬ���Ǥ����ס�

������ˡ��쥤�䡼���ʾ�Υ��ץꥱ��������ư�������Ĵ�٤������ʤ⤢�롣�㤨�С�HTTP�μ��Ǥ���GET�ꥯ�����Ȥ˥ǡ����١��������ץ�������ե�������ץ������Ҥ��뤳�Ȥǡ�Web�����С��ΥХå�����ɤˤ���ǡ����١����������С��䡤���ץꥱ����������С��ʤɤΥإ륹�������å����ǽ�Ȥʤ롣

�ȥåץڡ�����