●インストール方法

参考URL:VMware vSphere Hypervisor ESXi 6.5 インストール&構築手順

上記を参照してインストールしました。

おまけ

参考URL:【VMware ESXi】各種管理用設定について【IP アドレス設定】

(広告ブロックを無効にする必要あり)

●2つ目のNICに対する仮想スイッチの追加

参考URL:【VMWare ESXi】図解 仮想ネットワーク・仮想スイッチの概要

ブラウザでESXiの管理画面にログインします。

下記の手順で作成します。記載していない設定項目はデフォルトの値のままとなります。

左ペインのナビゲーターから「ネットワーク」をクリックします。

「仮想スイッチ」タブをクリック

「標準仮想スイッチの追加」をクリック

vSwitch名を記載

アップリンク1を選択

「追加」をクリック

「VMkernel NIC」タブをクリック

「VMkernel NICの追加」をクリック

新規ポート グループに任意の名称を記載

仮想スイッチを選択

IPv4設定

静的を選択

IPアドレスおよびネットマスクを記載

サービス

管理にチェック

「作成」をクリック

「ポートグループ」タブをクリック

「ポート グループの追加」をクリック

名前を記載

VLAN IDは 0 のまま

仮想スイッチを選択

「追加」をクリック

以上で新たな仮想スイッチの作成は完了です。

仮想OSに作成した仮想スイッチを割り当てます。

任意の仮想OSを選択

「編集」をクリック

「ネットワークアダプターの追加」をクリック

「ネットワークアダプター」を選択

「保存」をクリック

以上で作業は終了です。

●VMware ESXiにsshで接続するための設定方法

参考URL:SSH : サービスを起動する

ESXiホストにSSHでアクセスするには、デフォルトの設定でSSHサービスは無効となっていますので、SSHサービスを起動する必要があります。

ESXi Shell からコマンドで起動する場合は以下のように実行します。

ダイレクトコンソールからも有効化できます。

root ユーザーアカウントでログインし、[Troubleshooting Options] - [Enable SSH] で起動可能です。

●VMware ESXiにsshで接続するネットワークの制限方法

参考URL:ESXi ホストで許可される IP アドレスの追加

上記を設定することにより、SSH接続可能なネットワークを制限できるようになります。

●VMware ESXiのsshで公開鍵認証を利用する方法

参考URL:SSHで公開鍵認証を行う(必要であれば)

上記を設定することにより、公開鍵認証を利用できるようになります。

●VMware ESXiのにWeb管理画面に接続するネットワークの制限方法

参考URL:ESXi6.7のWeb管理画面のIPアクセス制限方法

上記を設定することにより、Web接続可能なネットワークを制限できるようになります。

●VMware ESXiのファイアウォールコマンドリファレンス

参考URL:ESXi ESXCLI ファイアウォールのコマンド

●NTPの設定

参考URL:NTP : 時刻同期の設定

時刻同期の設定はデフォルトで無効となっていますので、有効化します。

なお、ESXiでは、タイムゾーンはUTCのみとなっています。

●仮想マシンのWake on LANの設定方法

参考URL:仮想マシンの電力管理設定の管理

参考URL:【ESXi】【PowerShell】ゲストOSの起動にWake on LAN(Magic Packet)を使用

Wake on LAN機能をサポートしているのはWindowsのゲストOSのみです。VMware ToolsをインストールしているとWake on LANの設定ができないためあらかじめゲストOSからアンインストールする必要があります。

仮想マシンへのWake ON LAN設定手順は下記のとおりです。

Windows用のWake on LANソフトはWake on LAN for Windowsをダウンロードし、起動することを確認しました。

Linux(Cent OS 7)はnet-toolsインストールし、下記コマンドを実行することにより起動することを確認しました。

以上で作業は終了です。

●ESXiの時刻設定

参考URL:ESX/ESXi ホスト環境における時刻同期の確認

参考URL:VMwareでのハードウェアクロックとソフトウェアクロックの関係

時刻の確認方法は下記のとおりです。

●Syslog転送設定

参考URL:VMware ESXi Syslog転送設定手順

参考URL:ESXi6でesxcliコマンドを使ってシスログ転送設定する方法

参考URL:ねころくぶろぐ

VMware ESXiのSyslogを転送するには下記のように設定します。

・受信側の設定

・送信側の設定

syslogの設定状態を確認します。

Syslogの設定を無効にする場合は下記のとおりです。

Firewallを無効にする場合は下記のとおりです。

●バックアップ(エクスポート)について

参考URL:ESXi 仮想マシンのエクスポートに失敗しました:基礎になる接続が閉じられましたのエラー

参考URL:VVMwareで仮想OSをovfエクスポートしてOSクローンしてみる

参考URL:VMWare vSphere client タイムアウト設定

仮想ディスク(.vmdk)をリストアする際、2つ目の仮想ディスクをVMWare vSphere Web Clientを使用して元に戻すことができませんでした(原因不明)。SSH経由でコマンドを使用した方が良いかもしれません。

下記バージョンでバックアップ(以下、「エクスポート」という。)を実施したところ、「仮想マシンのエクスポートに失敗しました。操作がタイムアウトしました。」というエラーが発生しバックアップすることができませんでした。

VMware ESXi 6.5

VMWare vSphere Client 6.0

VMWare vSphere Web Clientでエクスポートしたところ正常に作業が完了しました。

クライアント側のバージョンに問題があったようです。

また、IE11を使用しているとダウンロードが途中で終了してしまいますので、FirefoxやChrome使用してください。

これはエクスポートだけでなくデプロイでも該当します。

●USB HDDを認識させる方法について

参考URL:ESXi 6.x USB データストア作成

参考URL:VMware vSphere Hypervisor 6.5(ESXi)に外付けUSB-HDDを接続してデータストアとして利用する

仮想マシンのディスク領域が少ないため、一時的に外付けUSB HDDを取り付けなければならなくなりました。

そのため、ESXi6.5でUSBを認識させるための作業が必要となりました。認識させるためにはVMwareサーバにSSHで接続する必要がありますので、事前にSSHで接続できる状態にしてください。

usbarbitratorサービスの停止、usbarbitratorサービスの自動起動無効化を実施します。

USB HDDのGPT設定をするため、下記コマンドを実行します。指定するデバイス名は環境に応じて異なりますので注意してください。

コマンドのAA31・・・は指定されているコマンドですので、そのまま記載してください。

GUI(VMWare vSphere Web Client)でログインします。

ナビゲータの左ペイン内のストレージをクリックします。

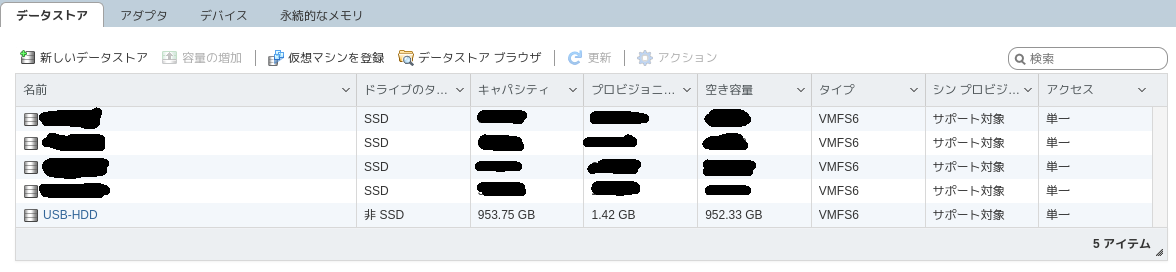

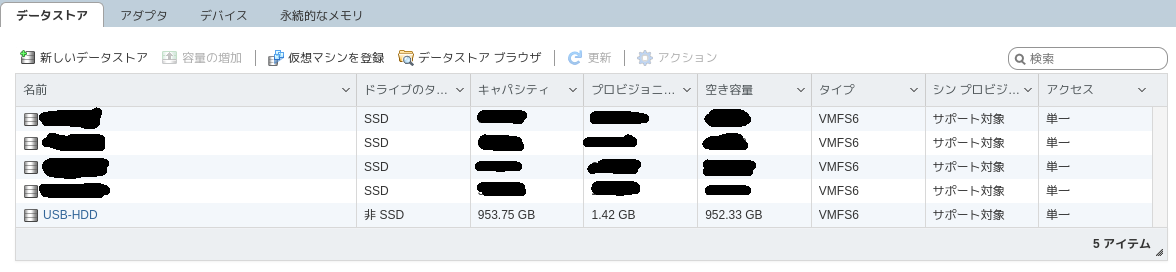

「USB-HDD」として認識されているかどうか確認します。認識されていない場合は「更新」クリックしてみてください。

問題なく認識されていれば、データストアとして利用できるようになります。

次に、仮想OSのHDDとして認識させる必要させます。

HDDを増やしたい仮想OSをシャットダウンします。

該当仮想OSの「編集(または、設定の編集)」ー「仮想ハードウェア」ー「ハードディスクの追加」ー「新規ハードディスク」をクリックします。

すると新たに「新規ハードディスク」が表示されます。

ただし、このままでは既存ハードディスクとなってしまいますので、「新規ハードディスク」の左側の下向き三角形をクリックし設定枠を広げます。

「地域」の「参照」をクリックし、追加したHDD(上記では、「USB-HDD」)を選択します。

必要に応じてディレクトリを作成(今回は「ホスト名_HDD」としました。)します。

その後、割り当てる容量を設定します。

その他の設定は、必要に応じて設定してください。

該当仮想OSを起動し、仮想OS側でフォーマットすることにより利用できるようになります。

設定を元に戻す方法は下記のとおりです。

●USB HDDを再認識させる方法について

上記の方法でUSB HDDをマウントできると、Host Clientのデータストアに下記の用(USB-HDDが今回マウントした対象)に表示されます。

何かしらの都合により、USB-HDDを再マウントする必要が生じる場合があります。

一度、アンマウントすると容易にマウントしてくれるわけではありません。

アンマウント後、該当USB HDDの電源を切ったり、USBケーブルを接続すると、上記の画面でマウントしてもマウントできない現象に陥ります。

その場合、sshで接続し「esxcfg-volume -l」を実行し、表示内容を確認します。

GUIでアンマウントできない(該当USB HDD上に、仮想ホストをクローン作成すると)ので、下記コマンドでアンマウントします。

ただし、「esxcfg-volume -l」を実行し、「Can mount: Yes」と表示されるのであれば、コマンドによりマウントできることが確認できました。

マウントができなくなるのは、下記のような場合です。

参考URL:Can mount: No (the original volume has some extents online) ESXi

●利用済みと認識される空き領域をデータストアとして認識させる

参考URL:VMWare ESXiの起動用USBメモリの空き領域をデータストアとして認識させる

SATAのHDDが一部読み取れなくなりアクセスできなくなってしまいました。

そのため「玄人志向 SSD/HDDスタンド 2.5型&3.5型対応 USB3.0接続 PCレスで高速クローン/3種のイレース可能/エラースキップ機能付き KURO-DACHI/CLONE+ERASE/ESKP」を購入し、新しいHDDにクローンコピーしました。

クローンコピー済みのHDDを接続しましたが、一部(2TBのうちの約1.8TB)が既に利用済みと認識されてしまいESXiの新しいデータストアとして利用することが出来ませんでした。

一部利用済みと認識されてしまう領域をWindowsのディスク管理で強制的に未使用領域として、再度HDDを接続しても同様の状況でした。

インターネットでいろいろ調べた結果、やり方が分かりました。

ESXiにSSHでログインします。

ディスク構成を確認します。

これをデータストアとして利用出来るようにします。

該当ディスクのパーティションリストを取得します。

パーティションの作成方法については、ESX および ESXi で partedUtil コマンドライン ユーティリティを使用する (1036609)を参照してください。

パーティションを作成します。

※パーティションテーブルを作るためにはすべてのパーティションの定義を記述する必要がありますので注意してください。

ただし、パーティションの最終セクタは 243201*255*63-1=3907024064 としたのが原因なのか不明ですが、VMware Host Clientでは空き容量 (2.49 MB)が表示されていました。

●コマンドによる操作

参考URL:VMware ESX仮想マシンをコマンドで操作

参考URL:VMware ESXi vim-cmd Command: A Quick Tutorial

参考URL:vimsh (vim-cmd) コマンドリファレンスA

参考URL:VMware ESXi 6 esxcliコマンドでネットワーク情報の取得

●仮想マシンをコマンドでコピーする方法

参考URL:ESX6.5で仮想マシンをコピーする

参考URL:シンvmdkをサイズそのままでコピーする

今回はfedora30-2という仮想マシンをfedora30-1という仮想マシンとして利用できるように作業します。

コピー先側のディレクトリは事前に作成しておく必要があります。

そのディレクトリ内に関連ファイルが存在しているとコピーができませんので注意してください。

仮想マシンのコピー等を実施する場合、最初に仮想ディスクのコピー作業を最初に実施し、その作業が終了後その他のファイルをコピーしてください。

sshでESXiホストにログインします。

fedora30-2の仮想ディスクをfedora30-1の仮想ディスクとしてクローニングします。

次に、vmxファイルを新しいfedora30-1.vmxという名前でコピーしてviで編集します。

仮想マシンが正常に起動しない場合、コピーしたファイル等を削除するなりして再度トライしてください。

●VMware上の仮想OSであるWindowsマシンのキーボードレイアウトを英語配列(US配列)から日本語配列(106JP配列)に修正する方法

参考URL:【未解決】【決定版…にしたいので助けてください】キーボードレイアウトを日本語にする

ここずっと何年も解決できなかったVMware上で動作する、Windowsのキーボード配列を日本語配列(106JP配列)にすることができました。

設定条件としては、「設定」-「時刻と地域」-「地域と言語」-「言語」で「日本語」が設定されており、その「日本語」をクリックした後に更に「オプション」をクリックし、「キーボードレイアウト」が「日本語キーボード(106/109キー)」で既に設定されている場合となります。

この条件時に下記の値を変更すると日本語キーボードとして認識されるようになり、@や\を想定とおり入力できるようになります。

レジストリエディタを起動し、下記の値を変更します。

●cactiによるVMwareの監視

参考URL:Cactiを使用したVMwareの監視

VMwareにSSHでログイン後、SNMPを動作させます。

●SNMP Trapを有効にする方法

参考URL:snmpd.conf 設定方法 (拡張MIBファイルの導入方法)

参考URL:[VMware] ESXi 6.7 で SNMP Trap 設定を有効にする

想定しているサーバは下記のとおりです。

SNMP Trapの設定にはESXiにSSHで接続する必要がありますので、VMware Host ClientからESXiに接続し、SSHとESXiシェルのサービスを起動しておきます。

現状を確認します。

Trapするように設定します。

トラップの試験をしてみます。

正常に受信できています。

●VMware用のMIBの設定

参考URL:Vmwareのsnmpの拡張MIBを設定する

参考URL:VMware ESXi SNMPの設定

snmpwalkコマンドなどの取得した結果が数字の羅列でよくわからない場合があるので、MIB情報をインストールします。

VMwareの最新のMIB情報はこちらのあります。

●VMware Esxiのアップデート方法

参考URL:[VMware] ESXi 6.5 から 6.7 へアップデートし最新のパッチを適用する

参考URL:VMware ESXiに重大な脆弱性、アップデートを

参考URL:ESXi Version 6.7.0 History

2020年4月28日にVMware ESXiに重大な脆弱性について情報が公開(脆弱性は深刻度が重大(Important)に分類)されました。

アップデートを実施したときの方法をメモとして残しておきます。

パッチ情報はVMSA-2020-0008に記載されています。

ESXiのバージョンを確認後、「Fixed Version」のリンクをクリックしアカウント情報を入力しダウンロードします。

今回は下記で選択しました。

Select a Product:ESXi (Embedded and Installable)

Select Version:6.7.0

その後「Search」をクリックすると各種パッチが表示されます。

今回適用するパッチは最新のパッチですので「ESXi670-202004002」をダウンロードします。

ダウンロードしたファイルをESXiのデータストアへアップロードします。

今回は「update」というフォルダを作成し、そこにWinSCPを使用してアップロードしました。

アップデート対象のESXiで稼働するすべての仮想マシンを停止します。

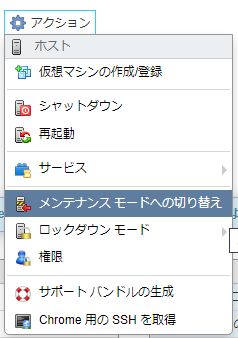

その後、GUIでメンテナンスモードへと切り替えます。

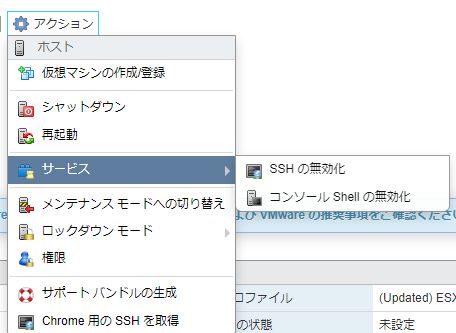

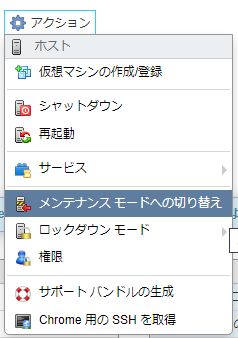

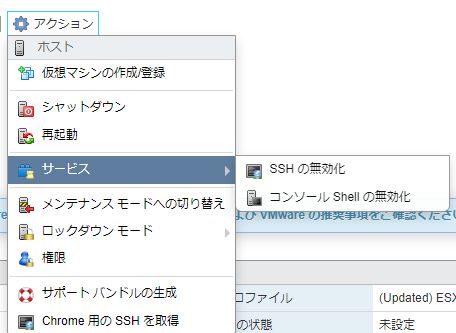

ESXiに対し、SSH接続するので「アクション」-「サービス」で「SSHの有効化」と「コンソールシェルの有効化」をします。

下図は既にSSH及びコンソールシェルが有効化が有効化であるため、無効化として表示されています。

ESXiにログインできたらまずは現在のビルド番号などを確認しておきます。

実際のコマンド

再起動するとSSHの有効化とコンソールシェルの有効化がリセットされてしまうことがあるので注意が必要です。

正常にBuild Number:16075168へアップデートされました。

●アップデート時にHardwareErrorと表示された場合の対処

参考URL:Vmware ESXi に関する覚え書き

参考URL:ESXiマイナーバージョンアップ

アップデート実行時に下記のようなエラーが表示される場合があります。

これは、自作のハードウェアや使用しているサーバの一部のハードウェアが古い等の理由でサポート対象外の時に表示されます。

2021年にヤフオクで落札したPrecision 5820 Towerでは、HardwareErrorが表示されました。

ハードウェア環境によっては、動作しなくなる場合があるかもしれませんのでご注意下さい。

対処するには、サポート有無を無視ということで「--no-hardware-warning」オプションでバージョンアップすることができます。

「Reboot Required: true」と出力されていますので、rebootします。

●ESXi 6.7u3においてNVMe SSDのS.M.A.R.Tの値がおかしい

参考URL: ESXi 6.7u3においてNVMe SSDのS.M.A.R.Tの値がおかしい

VMware ESXi 6.7u3で下記のようなログが30分ごとにsyslogで記録されます。

●ESXi CLIを使用した移行後のVMFSボリュームの再マウント

参考URL:ESXi CLI を使用した移行後の VMFS ボリュームの再マウント

ワークステーション更新のため、ハードディスクをそのまま移行しました。

新ハードウェアでハイパーバイザーは問題なく起動したのですが、これまで使用してきた別HDDのVMFSボリュームのデータストアが認識されずに悩んでいました。

ハイパーバイザーに再認識させる方法が分かりましたので記載します。

SSHを使用して、ESXiサーバコにログインします。

新しく追加されたLUNと既存のVMFS署名およびVMFSラベルを表示します。

データストア名の「 (1)」が邪魔なので、WebClientで該当部分を削除しました。

●Rocky Linux 8.4のインストールDVDが認識しない

参考URL:【RockyLinux】ダウンロードとインストール(VMware環境)まで

VMware Esxi 7.0にRocky Linux 8.4を新規作成してインストールしようとしたところ、「EFI VMware Virtual SATA CDROM Drive (0.0)… Not Found.」が表示されインストールできませんでした。

原因は、新規仮想マシン作成時に「起動オプション」のセキュアブートのチェックを外す必要があるということでした。

Rocky Linux 8.5以降は、上記を気にすること無くインストールできるようになりました。

参考URL:VMware vSphere Hypervisor ESXi 6.5 インストール&構築手順

上記を参照してインストールしました。

おまけ

参考URL:【VMware ESXi】各種管理用設定について【IP アドレス設定】

(広告ブロックを無効にする必要あり)

●2つ目のNICに対する仮想スイッチの追加

参考URL:【VMWare ESXi】図解 仮想ネットワーク・仮想スイッチの概要

ブラウザでESXiの管理画面にログインします。

下記の手順で作成します。記載していない設定項目はデフォルトの値のままとなります。

左ペインのナビゲーターから「ネットワーク」をクリックします。

「仮想スイッチ」タブをクリック

「標準仮想スイッチの追加」をクリック

vSwitch名を記載

アップリンク1を選択

「追加」をクリック

「VMkernel NIC」タブをクリック

「VMkernel NICの追加」をクリック

新規ポート グループに任意の名称を記載

仮想スイッチを選択

IPv4設定

静的を選択

IPアドレスおよびネットマスクを記載

サービス

管理にチェック

「作成」をクリック

「ポートグループ」タブをクリック

「ポート グループの追加」をクリック

名前を記載

VLAN IDは 0 のまま

仮想スイッチを選択

「追加」をクリック

以上で新たな仮想スイッチの作成は完了です。

仮想OSに作成した仮想スイッチを割り当てます。

任意の仮想OSを選択

「編集」をクリック

「ネットワークアダプターの追加」をクリック

「ネットワークアダプター」を選択

「保存」をクリック

以上で作業は終了です。

●VMware ESXiにsshで接続するための設定方法

参考URL:SSH : サービスを起動する

ESXiホストにSSHでアクセスするには、デフォルトの設定でSSHサービスは無効となっていますので、SSHサービスを起動する必要があります。

ESXi Shell からコマンドで起動する場合は以下のように実行します。

# 起動する [root@vmware:~] vim-cmd hostsvc/start_ssh # 自動起動を有効にする [root@vmware:~] vim-cmd hostsvc/enable_ssh # 停止する [root@vmware:~] vim-cmd hostsvc/stop_ssh # 自動起動を無効にする [root@vmware:~] vim-cmd hostsvc/disable_ssh

ダイレクトコンソールからも有効化できます。

root ユーザーアカウントでログインし、[Troubleshooting Options] - [Enable SSH] で起動可能です。

●VMware ESXiにsshで接続するネットワークの制限方法

参考URL:ESXi ホストで許可される IP アドレスの追加

上記を設定することにより、SSH接続可能なネットワークを制限できるようになります。

●VMware ESXiのsshで公開鍵認証を利用する方法

参考URL:SSHで公開鍵認証を行う(必要であれば)

上記を設定することにより、公開鍵認証を利用できるようになります。

●VMware ESXiのにWeb管理画面に接続するネットワークの制限方法

参考URL:ESXi6.7のWeb管理画面のIPアクセス制限方法

上記を設定することにより、Web接続可能なネットワークを制限できるようになります。

●VMware ESXiのファイアウォールコマンドリファレンス

参考URL:ESXi ESXCLI ファイアウォールのコマンド

| コマンド | 説明 |

|---|---|

| esxcli network firewall get | ファイアウォールのステータス(有効または無効)を返し、デフォルトのアクションのリストを表示します。 |

| esxcli network firewall set --default-action | デフォルトのアクションをパスに設定するには、true に設定します。デフォルトのアクションをドロップに設定するには、false に設定します。 |

| esxcli network firewall set --enabled | ESXi のファイアウォールを有効または無効にします。 |

| esxcli network firewall load | ファイアウォール モジュールとルール セットの構成ファイルをロードします。 |

| esxcli network firewall refresh | ファイアウォール モジュールがロードされている場合に、ルール セット ファイルを読み取ることでファイアウォールの構成を更新します。 |

| esxcli network firewall unload | フィルタを破棄し、ファイアウォール モジュールをアンロードします。 |

| esxcli network firewall ruleset list | ルール セット情報を一覧表示します。 |

| esxcli network firewall ruleset set --allowed-all | すべての IP アドレスへのすべてのアクセスを許可するには true に設定し、許可された IP アドレスのリストを使用するには false に設定します。 |

| esxcli network firewall ruleset set --enabled --ruleset-id=<string> | 指定したルールセットを有効にするには、有効を true に設定します。指定したルールセットを無効にするには、有効を false に設定します。 |

| esxcli network firewall ruleset allowedip list | 指定したルール セットの許可された IP アドレスを一覧表示します。 |

| esxcli network firewall ruleset allowedip add | 指定した IP アドレスまたは一定範囲内の IP アドレスからルール セットへのアクセスを許可します。 |

| esxcli network firewall ruleset allowedip remove | 指定した IP アドレスまたは一定範囲内の IP アドレスからルール セットへのアクセスを解除します |

| esxcli network firewall ruleset rule list | ファイアウォール内の各ルールセットのルールをリストします。 |

●NTPの設定

参考URL:NTP : 時刻同期の設定

時刻同期の設定はデフォルトで無効となっていますので、有効化します。

なお、ESXiでは、タイムゾーンはUTCのみとなっています。

# NTPの動作状態の確認

[root@vmware:~] esxcli system ntp get

Enabled: false

Loglevel: warning

PID: 0

Runtime Seconds: 0

Servers:

Service Providing Kernel Time:

Time Service Enabled: false

Time Synchronized: false

# 同期先のNTPサーバを設定してサービスを有効化

# esxcli system ntp set --server=[ntp server1] --server=[ntp server2] .....

[root@vmware:~] esxcli system ntp set --server=192.168.0.254 --server=ntp.nict.jp

[root@vmware:~] esxcli system ntp set --enabled=yes

[root@vmware:~] esxcli system ntp get

Enabled: true

Loglevel: warning

PID: 262861

Runtime Seconds: 450

Servers: 192.168.0.254, ntp.nict.jp

Service Providing Kernel Time: Network Time Protocol

Time Service Enabled: true

Time Synchronized: true

# 動作確認

[root@vmware:~] ntpq -p

remote refid st t when poll reach delay offset jitter

==============================================================================

dns.srv.world 61.205.120.130 2 u 1 64 1 0.306 +0.034 0.000

ntp-b3.nict.go. .NICT. 1 u 1 64 1 20.940 +1.203 0.000

[root@vmware:~] chkconfig ntpd

ntpd on

[root@vmware:~] esxcli network firewall ruleset rule list | grep ntp

ntpClient Outbound UDP Dst 123 123

以上で設定完了です。

●仮想マシンのWake on LANの設定方法

参考URL:仮想マシンの電力管理設定の管理

参考URL:【ESXi】【PowerShell】ゲストOSの起動にWake on LAN(Magic Packet)を使用

Wake on LAN機能をサポートしているのはWindowsのゲストOSのみです。VMware ToolsをインストールしているとWake on LANの設定ができないためあらかじめゲストOSからアンインストールする必要があります。

仮想マシンへのWake ON LAN設定手順は下記のとおりです。

- ブラウザを開く。

- VMware Host Client(例:https://192.168.0.1/ui/#/host)のページへ移動する。

- [ナビゲータ]パネルの[仮想マシン]のツリーノードを展開。

- Wake on LANを設定したいのVM(Windowsマシン)を選択。

- [パワーオン]ボタン押下。

- ゲストOS起動後、プログラムの削除から、VMWare Toolsをアンインストール。

- ゲストOSをシャットダウン。

- 該当VMを右クリック。

- [設定の編集]を選択。

- [ネットワークアダプタ1](Wake on Lan対象のNIC)のツリーノードを展開。

- [アダプタ タイプ]を[E1000e]を[VMXNET3]に変更。

- [仮想マシンオプション]を選択。

- [電源管理]のツリーノードを展開。

- [スタンバイ応答]で[仮想マシンをサスペンドにします。]を選択。

- [Wake on LAN]で[ネットワークアダプタ1](VM Network)]にチェックを入れる。

- [保存]ボタン押下。

- 該当マシンの[パワーオン]ボタン押下。

- VMWare Toolsをインストール。

Windows用のWake on LANソフトはWake on LAN for Windowsをダウンロードし、起動することを確認しました。

Linux(Cent OS 7)はnet-toolsインストールし、下記コマンドを実行することにより起動することを確認しました。

$ sudo ether-wake -i eth0 [MACアドレス]短くしたスリープ時間を元に戻します。

以上で作業は終了です。

●ESXiの時刻設定

参考URL:ESX/ESXi ホスト環境における時刻同期の確認

参考URL:VMwareでのハードウェアクロックとソフトウェアクロックの関係

時刻の確認方法は下記のとおりです。

システムクロックの確認 [root@esxi:~] esxcli system time get 2018-08-17T10:40:02Z ハードウェアクロックの確認 [root@esxi:~] esxcli hardware clock get 2018-08-17T10:40:06Z

システムクロックの設定 [root@esxi:~] esxcli system time set -d 16 -H 19 -m 28 -M 08 -y 2018 ハードウェアクロックの設定 [root@esxi:~] esxcli hardware clock set -d 16 -H 19 -m 29 -M 08 -y 2018

●Syslog転送設定

参考URL:VMware ESXi Syslog転送設定手順

参考URL:ESXi6でesxcliコマンドを使ってシスログ転送設定する方法

参考URL:ねころくぶろぐ

VMware ESXiのSyslogを転送するには下記のように設定します。

・受信側の設定

# vi /etc/rsyslog.conf # Provides UDP syslog reception $ModLoad imudp ← コメントアウト $UDPServerRun 514 ← コメントアウト # Provides TCP syslog reception #$ModLoad imtcp #$InputTCPServerRun 514 # systemctl restart rsyslog # firewall-cmd --add-port=514/udp --permanent # firewall-cmd --reload # firewall-cmd --list-port

・送信側の設定

syslogの設定状態を確認します。

esxcli system syslog config get

Remote Host: <none> ← このように表示される

Syslogの転送先のホストを指定します。

esxcli system syslog config set --loghost=udp://<IP Address>:514Syslogの設定状態を確認します。

esxcli system syslog config get

Remote Host: tcp://***.***.***.***:514; ← このように表示される

Firewallの設定を確認します。

esxcli network firewall ruleset list | grep syslog

syslog true ← Firewallが閉じている状態

Firewallに穴を開けます。

esxcli network firewall ruleset set --ruleset-id=syslog --enabled=trueFirewallを再読み込みします。

esxcli network firewall refreshFirewallの設定を確認します。

esxcli network firewall ruleset list | grep syslog

syslog true ← Firewallが開いている状態

Syslogサービスを再読み込み

esxcli system syslog reloadこれで転送されるようになります。

Syslogの設定を無効にする場合は下記のとおりです。

esxcli system syslog config set --reset=loghost esxcli system syslog reload

Firewallを無効にする場合は下記のとおりです。

esxcli network firewall ruleset set --ruleset-id=syslog --enabled=false esxcli network firewall refresh

●バックアップ(エクスポート)について

参考URL:ESXi 仮想マシンのエクスポートに失敗しました:基礎になる接続が閉じられましたのエラー

参考URL:VVMwareで仮想OSをovfエクスポートしてOSクローンしてみる

参考URL:VMWare vSphere client タイムアウト設定

仮想ディスク(.vmdk)をリストアする際、2つ目の仮想ディスクをVMWare vSphere Web Clientを使用して元に戻すことができませんでした(原因不明)。SSH経由でコマンドを使用した方が良いかもしれません。

下記バージョンでバックアップ(以下、「エクスポート」という。)を実施したところ、「仮想マシンのエクスポートに失敗しました。操作がタイムアウトしました。」というエラーが発生しバックアップすることができませんでした。

VMware ESXi 6.5

VMWare vSphere Client 6.0

VMWare vSphere Web Clientでエクスポートしたところ正常に作業が完了しました。

クライアント側のバージョンに問題があったようです。

また、IE11を使用しているとダウンロードが途中で終了してしまいますので、FirefoxやChrome使用してください。

これはエクスポートだけでなくデプロイでも該当します。

●USB HDDを認識させる方法について

参考URL:ESXi 6.x USB データストア作成

参考URL:VMware vSphere Hypervisor 6.5(ESXi)に外付けUSB-HDDを接続してデータストアとして利用する

仮想マシンのディスク領域が少ないため、一時的に外付けUSB HDDを取り付けなければならなくなりました。

そのため、ESXi6.5でUSBを認識させるための作業が必要となりました。認識させるためにはVMwareサーバにSSHで接続する必要がありますので、事前にSSHで接続できる状態にしてください。

usbarbitratorサービスの停止、usbarbitratorサービスの自動起動無効化を実施します。

$ ssh接続しているUSB HDDがESXiホストから認識できているか確認します。物理的に接続しているのに/dev下に表示されていない場合は、デバイスが認識されていませんので、Windows等でFATでにフォーマット後、再接続してください。-l root <パスワードの入力> [root@esxi:~] /etc/init.d/usbarbitrator stop [root@esxi:~] chkconfig usbarbitrator off

[root@esxi:~] ls /dev/disks/ naa.5000c*********** vml.02000000003001***********************f naa.5000c***********:1 vml.02000000003001***********************f:1 naa.5000c***********:2 vml.02000000005000c**********************0 naa.5000c***********:3 vml.02000000005000c**********************0:1 naa.5000c***********:5 vml.02000000005000c**********************0:2 naa.5000c***********:6 vml.02000000005000c**********************0:3 naa.5000c***********:7 vml.02000000005000c**********************0:5 naa.5000c***********:8 vml.02000000005000c**********************0:6 naa.5000c***********:9 vml.02000000005000c**********************0:7 naa.50014*********** vml.02000000005000c**********************0:8 naa.50014***********:2 vml.02000000005000c**********************0:9 naa.50014*********** vml.020000000050014**********************4 naa.50014***********:2 vml.020000000050014**********************4:2 naa.50014*********** vml.020000000050014**********************4 naa.50014***********:2 vml.020000000050014**********************4:2 t10.JMicron_Generic_________0**************F vml.020000000050014**********************4 t10.JMicron_Generic_________0**************F:1 vml.020000000050014**********************4:2t10で始まるものがUSB HDDです。

USB HDDのGPT設定をするため、下記コマンドを実行します。指定するデバイス名は環境に応じて異なりますので注意してください。

[root@esxi:~] partedUtil mklabel /dev/disks/t10.JMicron_Generic_________0**************F gptパーティション作成時にエンドセクタを指定する必要がありますので、下記コマンドを実行して値を算出します。

[root@esxi:~] eval expr $(partedUtil getptbl /dev/disks/t10.JMicron_Generic_________0**************F | \

tail -1 | awk '{print $1 " \\* " $2 " \\* " $3}') - 1

5860528064

算出した値を利用して、USBストレージに対してパーティションを設定します。

[root@esxi:~] partedUtil setptbl /dev/disks/t10.JMicron_Generic_________0**************F \

gpt "1 2048 5860528064 AA31E02A400F11DB9590000C2911D1B8 0"

上記手順でパーティションを一つ作成していますので、そのパーティションに対してフォーマットを実行します。

コマンドのAA31・・・は指定されているコマンドですので、そのまま記載してください。

[root@esxi:~] vmkfstools -C vmfs5 -S USB-HDD /dev/disks/t10.JMicron_Generic_________0**************F:1

create fs deviceName:'/dev/disks/t10.JMicron_Generic_________0**************F:1', fsShortName:'vmfs5', fsName:'USB-HDD'

deviceFullPath:/dev/disks/t10.JMicron_Generic_________0**************F:1 deviceFile:t10.JMicron_Generic_________0**************F:1

ATS on device /dev/disks/t10.JMicron_Generic_________0**************F:1: not supported

.

Checking if remote hosts are using this device as a valid file system. This may take a few seconds...

Creating vmfs5 file system on "t10.JMicron_Generic_________01**************F:1" with blockSize 1048576 and volume label "USB-HDD".

Successfully created new volume: 5bcbe28a-d******7-fdfd-0**********6

Successfully created new volumeと表示されたらフォーマット完了です。

GUI(VMWare vSphere Web Client)でログインします。

ナビゲータの左ペイン内のストレージをクリックします。

「USB-HDD」として認識されているかどうか確認します。認識されていない場合は「更新」クリックしてみてください。

問題なく認識されていれば、データストアとして利用できるようになります。

次に、仮想OSのHDDとして認識させる必要させます。

HDDを増やしたい仮想OSをシャットダウンします。

該当仮想OSの「編集(または、設定の編集)」ー「仮想ハードウェア」ー「ハードディスクの追加」ー「新規ハードディスク」をクリックします。

すると新たに「新規ハードディスク」が表示されます。

ただし、このままでは既存ハードディスクとなってしまいますので、「新規ハードディスク」の左側の下向き三角形をクリックし設定枠を広げます。

「地域」の「参照」をクリックし、追加したHDD(上記では、「USB-HDD」)を選択します。

必要に応じてディレクトリを作成(今回は「ホスト名_HDD」としました。)します。

その後、割り当てる容量を設定します。

その他の設定は、必要に応じて設定してください。

該当仮想OSを起動し、仮想OS側でフォーマットすることにより利用できるようになります。

設定を元に戻す方法は下記のとおりです。

$ ssh <VMwareのIPアドレス> -l root <パスワードの入力> [root@esxi:~] /etc/init.d/usbarbitrator start [root@esxi:~] chkconfig usbarbitrator onただし、すでにESXiでUSBを使用している場合、usbarbitratorをstartさせるとSSHがフリーズする可能性が高いので、継続的に使用する場合は停止状態にしておくことをお薦めします。

●USB HDDを再認識させる方法について

上記の方法でUSB HDDをマウントできると、Host Clientのデータストアに下記の用(USB-HDDが今回マウントした対象)に表示されます。

何かしらの都合により、USB-HDDを再マウントする必要が生じる場合があります。

一度、アンマウントすると容易にマウントしてくれるわけではありません。

アンマウント後、該当USB HDDの電源を切ったり、USBケーブルを接続すると、上記の画面でマウントしてもマウントできない現象に陥ります。

その場合、sshで接続し「esxcfg-volume -l」を実行し、表示内容を確認します。

※USBケーブルを接続したまま、電源OFF→ONでは下記で対応できた

esxcfg-volume -l

Scanning for VMFS-6 host activity (4096 bytes/HB, 1024 HBs).

VMFS UUID/label: 6********-********-****-***********d/USB-HDD

Can mount: Yes

Can resignature: Yes

Extent name: mpx.vmhba**:C0:T0:L0:1 range: 0 - 976639 (MB)

「Can mount: Yes」のように表示されていれば、下記のコマンドでマウントできます。

esxcfg-volume -m 6********-********-****-***********d USB-HDD Mounting volume 6********-********-****-***********d

GUIでアンマウントできない(該当USB HDD上に、仮想ホストをクローン作成すると)ので、下記コマンドでアンマウントします。

esxcfg-volume -u 6********-********-****-***********d USB-HDD Umounting volume /vmfs/volumes/6********-********-****-***********d [ConfigStore:371713207872:] DeleteSubObject: Could not find key: snap_volumeこの後、何故かGUIではマウント・アンマウントできなくなります。

ただし、「esxcfg-volume -l」を実行し、「Can mount: Yes」と表示されるのであれば、コマンドによりマウントできることが確認できました。

マウントができなくなるのは、下記のような場合です。

sxcfg-volume -l

Scanning for VMFS-6 host activity (4096 bytes/HB, 1024 HBs).

VMFS UUID/label: 6********-********-****-***********d/USB-HDD

Can mount: No (the original volume has some extents online)

Can resignature: Yes

Extent name: mpx.vmhba**:C0:T0:L0:1 range: 0 - 976639 (MB)

マウントしようとしてもエラーとなります。

esxcfg-volume -m 6********-********-****-***********d USB-HDD Mounting volume 6********-********-****-***********d Error: Unable to mount this VMFS volume due to the original volume has some extents onlineこれを解消するには、下記のようにします。

参考URL:Can mount: No (the original volume has some extents online) ESXi

esxcli storage vmfs snapshot resignature -u 6********-********-****-***********d esxcli storage vmfs snapshot list esxcfg-volume -l ※何も表示されなくなります しばらくすると esxcfg-volume -l Scanning for VMFS-6 host activity (4096 bytes/HB, 1024 HBs). VMFS UUID/label: 6********-********-****-***********d/snap-********-USB-HDD Can mount: Yes Can resignature: Yes Extent name: mpx.vmhba40:C0:T0:L0:1 range: 0 - 976639 (MB) デバイス名が変わっていますが、マウントする時はこれまでのデバイス名でマウントできました。 esxcfg-volume -m 6********-********-****-***********d USB-HDD Mounting volume 6********-********-****-***********dただし、Host ClientのGUIでは「snap-********-USB-HDD」に変わりました。

●利用済みと認識される空き領域をデータストアとして認識させる

参考URL:VMWare ESXiの起動用USBメモリの空き領域をデータストアとして認識させる

SATAのHDDが一部読み取れなくなりアクセスできなくなってしまいました。

そのため「玄人志向 SSD/HDDスタンド 2.5型&3.5型対応 USB3.0接続 PCレスで高速クローン/3種のイレース可能/エラースキップ機能付き KURO-DACHI/CLONE+ERASE/ESKP」を購入し、新しいHDDにクローンコピーしました。

クローンコピー済みのHDDを接続しましたが、一部(2TBのうちの約1.8TB)が既に利用済みと認識されてしまいESXiの新しいデータストアとして利用することが出来ませんでした。

一部利用済みと認識されてしまう領域をWindowsのディスク管理で強制的に未使用領域として、再度HDDを接続しても同様の状況でした。

インターネットでいろいろ調べた結果、やり方が分かりました。

ESXiにSSHでログインします。

ディスク構成を確認します。

[root@esxi:~] ls /dev/disks/ mpx.vmhba32:C0:T0:L0 naa.50014ee264f97931:5 vml.020000000050014ee264f97931574443205744 mpx.vmhba32:C0:T0:L0:1 naa.50014ee264f97931:6 vml.020000000050014ee264f97931574443205744:1 naa.50014ee057bbc824 naa.50014ee264f97931:7 vml.020000000050014ee264f97931574443205744:2 naa.50014ee057bbc824:1 naa.50014ee2ae008113 vml.020000000050014ee264f97931574443205744:3 naa.50014ee206cfd86b naa.50014ee2ae008113:2 vml.020000000050014ee264f97931574443205744:4 naa.50014ee206cfd86b:2 vml.01000000003031323334353637383941424344454655534220746f vml.020000000050014ee264f97931574443205744:5 naa.50014ee264f97931 vml.01000000003031323334353637383941424344454655534220746f:1 vml.020000000050014ee264f97931574443205744:6 naa.50014ee264f97931:1 vml.020000000050014ee057bbc824574443205744 vml.020000000050014ee264f97931574443205744:7 naa.50014ee264f97931:2 vml.020000000050014ee057bbc824574443205744:1 vml.020000000050014ee2ae008113574443205744 naa.50014ee264f97931:3 vml.020000000050014ee206cfd86b574443205744 vml.020000000050014ee2ae008113574443205744:2 naa.50014ee264f97931:4 vml.020000000050014ee206cfd86b574443205744:2今回、利用済みと認識されてしまうのはnaa.50014ee264f97931のパーティション8番目の領域です(VMware Host Clientで確認)。

これをデータストアとして利用出来るようにします。

該当ディスクのパーティションリストを取得します。

[root@esxi:~] partedUtil getptbl /dev/disks/naa.50014ee264f97931

gpt

243201 255 63 3907029168

1 64 8191 C12A7328F81F11D2BA4B00A0C93EC93B systemPartition 128

2 8224 520191 EBD0A0A2B9E5443387C068B6B72699C7 linuxNative 0

3 520224 1032191 EBD0A0A2B9E5443387C068B6B72699C7 linuxNative 0

4 1032224 1257471 9D27538040AD11DBBF97000C2911D1B8 vmkDiagnostic 0

5 1257504 1843199 EBD0A0A2B9E5443387C068B6B72699C7 linuxNative 0

6 1843200 7086079 9D27538040AD11DBBF97000C2911D1B8 vmkDiagnostic 0

7 7086080 15472639 EBD0A0A2B9E5443387C068B6B72699C7 linuxNative 0

パーティションの最終セクタは 243201*255*63-1=3907024064 となります。

パーティションの作成方法については、ESX および ESXi で partedUtil コマンドライン ユーティリティを使用する (1036609)を参照してください。

パーティションを作成します。

※パーティションテーブルを作るためにはすべてのパーティションの定義を記述する必要がありますので注意してください。

[root@esxi:~] partedUtil setptbl "/dev/disks/naa.50014ee264f97931" gpt "1 64 8191 C12A7328F81F11D2BA4B00A0C93EC93B 128" "2 8224 520191 \

EBD0A0A2B9E5443387C068B6B72699C7 0" "3 520224 1032191 EBD0A0A2B 9E5443387C068B6B72699C7 0" "4 1032224 1257471 \

9D27538040AD11DBBF97000C2911D1B8 0" "5 1257504 1843199 EBD0A0A2B9E5443387C068B6B72699C7 0" "6 1843200 7086079 \

9D27538040AD11DBBF97000C2911D1B8 0" "7 7086080 15472639 EBD0A0A2B9E5443387C068B6B72699C7 0" "8 15472672 3907024064 \

AA31E02A400F11DB9590000C2911D1B8 0"

gpt

0 0 0 0

1 64 8191 C12A7328F81F11D2BA4B00A0C93EC93B 128

2 8224 520191 EBD0A0A2B9E5443387C068B6B72699C7 0

3 520224 1032191 EBD0A0A2B9E5443387C068B6B72699C7 0

4 1032224 1257471 9D27538040AD11DBBF97000C2911D1B8 0

5 1257504 1843199 EBD0A0A2B9E5443387C068B6B72699C7 0

6 1843200 7086079 9D27538040AD11DBBF97000C2911D1B8 0

7 7086080 15472639 EBD0A0A2B9E5443387C068B6B72699C7 0

8 15472672 3907024064 AA31E02A400F11DB9590000C2911D1B8 0

パーティションが正常に作成されたかどうか確認します。

[root@esxi:~] partedUtil getptbl /dev/disks/naa.50014ee264f97931

gpt

243201 255 63 3907029168

1 64 8191 C12A7328F81F11D2BA4B00A0C93EC93B systemPartition 128

2 8224 520191 EBD0A0A2B9E5443387C068B6B72699C7 linuxNative 0

3 520224 1032191 EBD0A0A2B9E5443387C068B6B72699C7 linuxNative 0

4 1032224 1257471 9D27538040AD11DBBF97000C2911D1B8 vmkDiagnostic 0

5 1257504 1843199 EBD0A0A2B9E5443387C068B6B72699C7 linuxNative 0

6 1843200 7086079 9D27538040AD11DBBF97000C2911D1B8 vmkDiagnostic 0

7 7086080 15472639 EBD0A0A2B9E5443387C068B6B72699C7 linuxNative 0

8 15472672 3907024064 AA31E02A400F11DB9590000C2911D1B8 vmfs 0

パーディーションをvmfsでフォーマットします。

[root@esxi:~] vmkfstools -C vmfs6 -S datastore1 /dev/disks/naa.50014ee264f97931:8

create fs deviceName:'/dev/disks/naa.50014ee264f97931:8', fsShortName:'vmfs6', fsName:'datastore1'

deviceFullPath:/dev/disks/naa.50014ee264f97931:8 deviceFile:naa.50014ee264f97931:8

ATS on device /dev/disks/naa.50014ee264f97931:8: not supported

.

Checking if remote hosts are using this device as a valid file system. This may take a few seconds...

Creating vmfs6 file system on "naa.50014ee264f97931:8" with blockSize 1048576, unmapGranularity 1048576, \

unmapPriority default and volume label "datastore1".

Successfully created new volume: 5f1e77b6-6f38ed66-3a87-0004239f1916

ディスク構成及び・・・を確認します。

[root@esxi:~] ls /dev/disks/ mpx.vmhba32:C0:T0:L0 naa.50014ee264f97931:6 vml.020000000050014ee264f97931574443205744:1 mpx.vmhba32:C0:T0:L0:1 naa.50014ee264f97931:7 vml.020000000050014ee264f97931574443205744:2 naa.50014ee057bbc824 naa.50014ee264f97931:8 vml.020000000050014ee264f97931574443205744:3 naa.50014ee057bbc824:1 naa.50014ee2ae008113 vml.020000000050014ee264f97931574443205744:4 naa.50014ee206cfd86b naa.50014ee2ae008113:2 vml.020000000050014ee264f97931574443205744:5 naa.50014ee206cfd86b:2 vml.01000000003031323334353637383941424344454655534220746f vml.020000000050014ee264f97931574443205744:6 naa.50014ee264f97931 vml.01000000003031323334353637383941424344454655534220746f:1 vml.020000000050014ee264f97931574443205744:7 naa.50014ee264f97931:1 vml.020000000050014ee057bbc824574443205744 vml.020000000050014ee264f97931574443205744:8 naa.50014ee264f97931:2 vml.020000000050014ee057bbc824574443205744:1 vml.020000000050014ee2ae008113574443205744 naa.50014ee264f97931:3 vml.020000000050014ee206cfd86b574443205744 vml.020000000050014ee2ae008113574443205744:2 naa.50014ee264f97931:4 vml.020000000050014ee206cfd86b574443205744:2 naa.50014ee264f97931:5 vml.020000000050014ee264f97931574443205744 [root@esxi:~] ls /vmfs/volumes/ 0bb21b7f-d5ec4ea2-5b29-24d3ab793a1e 5f105485-9c734bc6-5j77-008e9339f1916 4f725e6f-9aeeef1e-d099-0004239f1916 datastore1 4k8d5e78-43b5dj89-10jd-09d8d39f1916 datastore2 4f725e79-240ed2ba-3f09-0004239f1916 datastore3 5a99d734-a9d8c269-d983-0983439f1916 fadf237a-b9315aaf-4cf6-1e27a5c132f1 [root@esxi:~] ls /vmfs/volumes/datastore1 [root@esxi:~] ls -l /vmfs/volumes/ total 4096 : lrwxr-xr-x 1 root root 35 Jul 27 07:14 datastore1 -> 5f1e77b6-6f38ed66-3a87-0004239f1916 :VMware Host Clientで確認しても問題ありませんでした。

ただし、パーティションの最終セクタは 243201*255*63-1=3907024064 としたのが原因なのか不明ですが、VMware Host Clientでは空き容量 (2.49 MB)が表示されていました。

●コマンドによる操作

参考URL:VMware ESX仮想マシンをコマンドで操作

参考URL:VMware ESXi vim-cmd Command: A Quick Tutorial

参考URL:vimsh (vim-cmd) コマンドリファレンスA

参考URL:VMware ESXi 6 esxcliコマンドでネットワーク情報の取得

●仮想マシンをコマンドでコピーする方法

参考URL:ESX6.5で仮想マシンをコピーする

参考URL:シンvmdkをサイズそのままでコピーする

今回はfedora30-2という仮想マシンをfedora30-1という仮想マシンとして利用できるように作業します。

コピー先側のディレクトリは事前に作成しておく必要があります。

そのディレクトリ内に関連ファイルが存在しているとコピーができませんので注意してください。

仮想マシンのコピー等を実施する場合、最初に仮想ディスクのコピー作業を最初に実施し、その作業が終了後その他のファイルをコピーしてください。

エラーの内容 Destination disk format: VMFS thin-provisioned Cloning disk '/vmfs/volumes/datastore1/win2016-11/win2016-11.vmdk'... Failed to clone disk: The file already exists (39).このエラーが表示されても何が原因が分かりにくいので注意が必要です。

sshでESXiホストにログインします。

[root@esxi ~]# ssh vmware Password: The time and date of this login have been sent to the system logs. VMware offers supported, powerful system administration tools. Please see www.vmware.com/go/sysadmintools for details. The ESXi Shell can be disabled by an administrative user. See the vSphere Security documentation for more information. [root@esxi:~]ログインできましたので、fedora30-1フォルダをストレージ上に作成します。

[root@esxi:~] cd /vmfs/volumes/datastore1/ [root@esxi:/vmfs/volumes/5a629245-e8c6afa7-8c4c-0004239f1916] mkdir fedora30-1 [root@esxi:/vmfs/volumes/5a629245-e8c6afa7-8c4c-0004239f1916] ls fedora30-1 fedora30-2 isoimages win10 win2016各仮想マシンのディレクトリ等を確認することができます。

fedora30-2の仮想ディスクをfedora30-1の仮想ディスクとしてクローニングします。

# シン・プロビジョニングで仮想ディスクを作成

[root@esxi:/vmfs/volumes/5a629245-e8c6afa7-8c4c-0004239f1916]

vmkfstools -i ./fedora30-2/fedora30-2_0.vmdk ./fedora30-1/fedora30-1_0.vmdk -d thin ← 実行コマンド

Destination disk format: VMFS thin-provisioned

Cloning disk './fedora30-2/fedora30-2_0.vmdk'...

Clone: 2% done.

しばらく時間がかかりますのでゆっくり待ちましょう。

次に、vmxファイルを新しいfedora30-1.vmxという名前でコピーしてviで編集します。

[root@esxi:/vmfs/volumes/5a629245-e8c6afa7-8c4c-0004239f1916] cp ./fedora30-2/fedora30-2.vmx ./fedora30-1/fedora30-1.vmx # コピーしたvmxファイルを編集 # 下記の例では、fedora30-2をfedora30-1に一括変換 [root@esxi:/vmfs/volumes/5a629245-e8c6afa7-8c4c-0004239f1916] vi ./fedora30-1/fedora30-1.vmx :%s/fedora30-2/fedora30-1/g最後に、ログファイル以外をすべてnode02ディレクトリへコピーします。

# ログファイル以外のファイルをコピーしてリネーム [root@esxi:/vmfs/volumes/5a629245-e8c6afa7-8c4c-0004239f1916] cp ./fedora30-2/fedora30-2.nvram ./fedora30-1/fedora30-1.nvram [root@esxi:/vmfs/volumes/5a629245-e8c6afa7-8c4c-0004239f1916] cp ./fedora30-2/fedora30-2.vmsd ./fedora30-1/fedora30-1.vmsd全て完了したら仮想マシンとして登録します。

[root@esxi:/vmfs/volumes/5a629245-e8c6afa7-8c4c-0004239f1916] vim-cmd solo/registervm /vmfs/volumes/datastore1/fedora30-1/fedora30-1.vmx 29これでクローニング作業は完了です。問題なく仮想マシンが起動すれば正常です。

仮想マシンが正常に起動しない場合、コピーしたファイル等を削除するなりして再度トライしてください。

●VMware上の仮想OSであるWindowsマシンのキーボードレイアウトを英語配列(US配列)から日本語配列(106JP配列)に修正する方法

参考URL:【未解決】【決定版…にしたいので助けてください】キーボードレイアウトを日本語にする

ここずっと何年も解決できなかったVMware上で動作する、Windowsのキーボード配列を日本語配列(106JP配列)にすることができました。

設定条件としては、「設定」-「時刻と地域」-「地域と言語」-「言語」で「日本語」が設定されており、その「日本語」をクリックした後に更に「オプション」をクリックし、「キーボードレイアウト」が「日本語キーボード(106/109キー)」で既に設定されている場合となります。

この条件時に下記の値を変更すると日本語キーボードとして認識されるようになり、@や\を想定とおり入力できるようになります。

レジストリエディタを起動し、下記の値を変更します。

HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Control\Keyboard Layouts\00000411 KBDJPN.DLL → KBD106.DLL再起動後、問題が解消されました。

●cactiによるVMwareの監視

参考URL:Cactiを使用したVMwareの監視

VMwareにSSHでログイン後、SNMPを動作させます。

# ssh vmware -l root [root@esxi:~] esxcli system snmp set --communities public [root@esxi:~] esxcli system snmp set --syscontact="bigbang" [root@esxi:~] esxcli system snmp set --syslocation="bigbang" [root@esxi:~] esxcli system snmp set --enable true [root@esxi:~] exitVMware上でSNMPが正常に動作しているか確認します。

[root@esxi:~] /etc/init.d/snmpd status snmpd is running設定内容は下記コマンドで確認できます。

[root@esxi:~] esxcli system snmp get仮想ホスト上以外からSNMP情報を取得するにはFirewallを設定します。

[root@esxi:~] esxcli network firewall ruleset set --ruleset-id snmp --allowed-all true [root@esxi:~] esxcli network firewall ruleset set --ruleset-id snmp --enabled trueFirewallのルールセットは下記コマンドで確認できます。

[root@esxi:~] esxcli network firewall ruleset listCactiサーバで下記コマンドを実行し、SNMP情報を取得できるか確認します。

# snmpwalk -v2c -c public <VMware ESXiのIPアドレス> SNMPv2-MIB::sysDescr.0 = STRING: VMware ESXi 7.*.* build-******** VMware, Inc. x86_64 SNMPv2-MIB::sysObjectID.0 = OID: SNMPv2-SMI::enterprises.6876.4.1 DISMAN-EVENT-MIB::sysUpTimeInstance = Timeticks: (27800) 0:04:38.00 SNMPv2-MIB::sysContact.0 = STRING: ********** SNMPv2-MIB::sysName.0 = STRING: vmware-server.bigbang.mydns.jp : : (以下、省略)

●SNMP Trapを有効にする方法

参考URL:snmpd.conf 設定方法 (拡張MIBファイルの導入方法)

参考URL:[VMware] ESXi 6.7 で SNMP Trap 設定を有効にする

想定しているサーバは下記のとおりです。

- SNMPマネージャー:CentOS 7

IPアドレス:192.168.0.5 - SNMPエージェント:VMware ESXi 6.7

IPアドレス: 192.168.0.98 - SNMPコミュニティ名: public

SNMP Trapの設定にはESXiにSSHで接続する必要がありますので、VMware Host ClientからESXiに接続し、SSHとESXiシェルのサービスを起動しておきます。

現状を確認します。

[root@vmware:~] esxcli system snmp get Authentication: Communities: Enable: false Engineid: Hwsrc: indications Largestorage: true Loglevel: warning Notraps: Port: 161 Privacy: Remoteusers: Syscontact: Syslocation: Targets: Users: V3targets:「Enable: false」となっていますのでサービスは起動していません。

Trapするように設定します。

[root@vmware:~] esxcli system snmp set -e=true -c=public -t=192.168.0.5@162/public設定を確認します。

Authentication: Communities: public Enable: true Engineid: 80001ADC0511035544663958372990 Hwsrc: indications Largestorage: true Loglevel: warning Notraps: Port: 161 Privacy: Remoteusers: Syscontact: Syslocation: Targets: 192.168.0.5@162 public Users: V3targets:「Enable: true」になり、サービスが起動していることが分かります。

トラップの試験をしてみます。

[root@vmware:~] esxcli system snmp test Comments: There is 1 target configured, send warmStart requested, test completed normally.SNMPマネージャのログを確認します。

[root@inu ~]# grep "snmptrapd" /var/log/messages

Jun 24 15:46:45 inu snmptrapd[1660]: 2021-06-24 15:46:45 192.168.0.98 (via UDP: [192.168.0.98]:10938->[192.168.0.5]:162) TRAP, SNMP v1, community public#012#011SNMPv2-MIB::snmpTraps Warm Start Trap (0) Uptime: 0:36:29.00

Jun 24 15:46:45 inu snmptrapd[1660]: 2021-06-24 15:46:45 192.168.0.98 (via UDP: [192.168.0.98]:10938->[192.168.0.5]:162) TRAP, SNMP v1, community public#012#011SNMPv2-MIB::snmpTraps Warm Start Trap (0) Uptime: 0:36:29.00

正常に受信できています。

●VMware用のMIBの設定

参考URL:Vmwareのsnmpの拡張MIBを設定する

参考URL:VMware ESXi SNMPの設定

snmpwalkコマンドなどの取得した結果が数字の羅列でよくわからない場合があるので、MIB情報をインストールします。

VMwareの最新のMIB情報はこちらのあります。

# cd /tmp # wget # unzip 1013445_VMware-mibs-6.7.A-13605115.zip # mkdir -P ~/.snmp/mibs # mv /tmp/vmw/* /usr/share/snmp/mibsトラップを使用している場合には、下記のように実行します。

# /etc/rc.d/init.d/snmptrapd restart

●VMware Esxiのアップデート方法

参考URL:[VMware] ESXi 6.5 から 6.7 へアップデートし最新のパッチを適用する

参考URL:VMware ESXiに重大な脆弱性、アップデートを

参考URL:ESXi Version 6.7.0 History

2020年4月28日にVMware ESXiに重大な脆弱性について情報が公開(脆弱性は深刻度が重大(Important)に分類)されました。

アップデートを実施したときの方法をメモとして残しておきます。

パッチ情報はVMSA-2020-0008に記載されています。

ESXiのバージョンを確認後、「Fixed Version」のリンクをクリックしアカウント情報を入力しダウンロードします。

今回は下記で選択しました。

Select a Product:ESXi (Embedded and Installable)

Select Version:6.7.0

その後「Search」をクリックすると各種パッチが表示されます。

今回適用するパッチは最新のパッチですので「ESXi670-202004002」をダウンロードします。

ダウンロードしたファイルをESXiのデータストアへアップロードします。

今回は「update」というフォルダを作成し、そこにWinSCPを使用してアップロードしました。

アップデート対象のESXiで稼働するすべての仮想マシンを停止します。

その後、GUIでメンテナンスモードへと切り替えます。

ESXiに対し、SSH接続するので「アクション」-「サービス」で「SSHの有効化」と「コンソールシェルの有効化」をします。

下図は既にSSH及びコンソールシェルが有効化が有効化であるため、無効化として表示されています。

ESXiにログインできたらまずは現在のビルド番号などを確認しておきます。

[root@esxi:~] esxcli system version get Product: VMware ESXi Version: 6.7.0 Build: Releasebuild-15820472 Update: 3 Patch: 94アップデートモジュール内のプロファイルを確認します。通常はこの中の -standard がつくものを使用します。

[root@esxi:~] esxcli software sources profile list --depot=/vmfs/volumes/<データストア名>/<フォルダ>/<アップデートモジュール>実際のコマンド

[root@esxi:~] esxcli software sources profile list --depot=/vmfs/volumes/datastore1/update/ESXi670-202004002.zip Name Vendor Acceptance Level Creation Time Modification Time -------------------------------- ------------ ---------------- ------------------- ------------------- ESXi-6.7.0-20200404001-standard VMware, Inc. PartnerSupported 2020-04-21T06:45:59 2020-04-21T06:45:59 ESXi-6.7.0-20200404001-no-tools VMware, Inc. PartnerSupported 2020-04-21T06:45:59 2020-04-21T06:45:59 ESXi-6.7.0-20200401001s-standard VMware, Inc. PartnerSupported 2020-04-21T06:45:59 2020-04-21T06:45:59 ESXi-6.7.0-20200401001s-no-tools VMware, Inc. PartnerSupported 2020-04-21T06:45:59 2020-04-21T06:45:59各プロファイルの意味は下記のとおりです。

- 末尾が「-standard」 標準イメージプロファイル

- 末尾が「-no-toosl」 no-tools イメージプロファイル

- 末尾が「s-standard」 セキュリティ更新のみを含むイメージプロファイル

- 末尾が「s-no-tools」 セキュリティ更新のみのno-tools イメージプロファイル

esxcli software profile update --profile=<プロファイル> --depot=/vmfs/volumes/<データストア名>/<フォルダ>/<アップデートモジュール> | moreメッセージに The update completed successfully と表示されれば成功です。

実際のコマンド

[root@esxi:~] esxcli software profile update --profile=ESXi-6.7.0-20200404001-standard --depot=/vmfs/volumes/datastore1/update/ESXi670-202004002.zip | more Update Result Message: The update completed successfully, but the system needs to be rebooted for the changes to be effective. Reboot Required: true適用が終わったらESXiを再起動してビルド番号などを確認します。

再起動するとSSHの有効化とコンソールシェルの有効化がリセットされてしまうことがあるので注意が必要です。

正常にBuild Number:16075168へアップデートされました。

[root@esxi:~] esxcli system version get Product: VMware ESXi Version: 6.7.0 Build: Releasebuild-16075168 Update: 3 Patch: 104

●アップデート時にHardwareErrorと表示された場合の対処

参考URL:Vmware ESXi に関する覚え書き

参考URL:ESXiマイナーバージョンアップ

アップデート実行時に下記のようなエラーが表示される場合があります。

これは、自作のハードウェアや使用しているサーバの一部のハードウェアが古い等の理由でサポート対象外の時に表示されます。

2021年にヤフオクで落札したPrecision 5820 Towerでは、HardwareErrorが表示されました。

ハードウェア環境によっては、動作しなくなる場合があるかもしれませんのでご注意下さい。

[HardwareError]

Hardware precheck of profile ESXi-7.0U3j-21053776-standard failed with warnings: <UNSUPPORTED_DEVICES WARNING: This host has unsupported devices [<PciInfo 'Ethernet controller [8086:105e 8086:115e]'>, <PciInfo 'Ethernet controller [8086:105e 8086:115e]'>]>

Apply --no-hardware-warning option to ignore the warnings and proceed with the transaction. Please refer to the log file for more details.

Hardware precheck of profile ESXi-7.0U3j-21053776-standard failed with warnings: <UNSUPPORTED_DEVICES WARNING: This host has unsupported devices [<PciInfo 'Ethernet controller [8086:105e 8086:115e]'>, <PciInfo 'Ethernet controller [8086:105e 8086:115e]'>]>

Apply --no-hardware-warning option to ignore the warnings and proceed with the transaction. Please refer to the log file for more details.

対処するには、サポート有無を無視ということで「--no-hardware-warning」オプションでバージョンアップすることができます。

[root@vmware2:~] esxcli software profile update --no-hardware-warning --profile=ESXi-7.0U3j-21053776-standard --depot=/vmfs/volumes/datastore1/VMware-ESXi-7.0U3j-21053776-depot.zip |

more

Update Result

Message: The update completed successfully, but the system needs to be rebooted for the changes to be effective.

Reboot Required: true

VIBs Installed: VMW_bootbank_atlantic_1.0.3.0-8vmw.703.0.20.19193900, VMW_bootbank_bnxtnet_216.0.50.0-44vmw.703.0.50.20036589, VMW_bootbank_bnxtroce_216.0.58.0-23vmw.703.0.50.20036589, VMW_bootbank_brcmfcoe_12.0.1500.2-3vmw.703.0.20.19193900, VMW_bootbank_elxiscsi_12.0.1200.0-9vmw.703.0.20.19193900, VMW_bootbank_elxnet_12.0.1250.0-5vmw.703.0.20.19193900, VMW_bootbank_i40en_1.11.1.31-1vmw.703.0.20.19193900, VMW_bootbank_iavmd_2.7.0.1157-2vmw.703.0.20.19193900, VMW_bootbank_icen_1.4.1.20-1vmw.703.0.50.20036589, VMW_bootbank_igbn_1.4.11.2-1vmw.703.0.20.19193900, VMW_bootbank_ionic-en_16.0.0-16vmw.703.0.20.19193900, VMW_bootbank_irdman_1.3.1.22-1vmw.703.0.50.20036589, VMW_bootbank_iser_1.1.0.1-1vmw.703.0.50.20036589, VMW_bootbank_ixgben_1.7.1.35-1vmw.703.0.20.19193900, VMW_bootbank_lpfc_14.0.169.26-5vmw.703.0.50.20036589, VMW_bootbank_lpnic_11.4.62.0-1vmw.703.0.20.19193900, VMW_bootbank_lsi-mr3_7.718.02.00-1vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt2_20.00.06.00-4vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt35_19.00.02.00-1vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt3_17.00.12.00-1vmw.703.0.20.19193900, VMW_bootbank_mtip32xx-native_3.9.8-1vmw.703.0.20.19193900, VMW_bootbank_ne1000_0.9.0-1vmw.703.0.50.20036589, VMW_bootbank_nenic_1.0.33.0-1vmw.703.0.20.19193900, VMW_bootbank_nfnic_4.0.0.70-1vmw.703.0.20.19193900, VMW_bootbank_nhpsa_70.0051.0.100-4vmw.703.0.20.19193900, VMW_bootbank_nmlx4-core_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx4-en_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx4-rdma_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx5-core_4.19.16.11-1vmw.703.0.20.19193900, VMW_bootbank_nmlx5-rdma_4.19.16.11-1vmw.703.0.20.19193900, VMW_bootbank_ntg3_4.1.8.0-4vmw.703.0.65.20842708, VMW_bootbank_nvme-pcie_1.2.3.16-1vmw.703.0.20.19193900, VMW_bootbank_nvmerdma_1.0.3.5-1vmw.703.0.20.19193900, VMW_bootbank_nvmetcp_1.0.0.1-1vmw.703.0.35.19482537, VMW_bootbank_nvmxnet3-ens_2.0.0.22-1vmw.703.0.20.19193900, VMW_bootbank_nvmxnet3_2.0.0.30-1vmw.703.0.20.19193900, VMW_bootbank_pvscsi_0.1-4vmw.703.0.20.19193900, VMW_bootbank_qcnic_1.0.15.0-14vmw.703.0.20.19193900, VMW_bootbank_qedentv_3.40.5.53-22vmw.703.0.20.19193900, VMW_bootbank_qedrntv_3.40.5.53-18vmw.703.0.20.19193900, VMW_bootbank_qfle3_1.0.67.0-22vmw.703.0.20.19193900, VMW_bootbank_qfle3f_1.0.51.0-22vmw.703.0.20.19193900, VMW_bootbank_qfle3i_1.0.15.0-15vmw.703.0.20.19193900, VMW_bootbank_qflge_1.1.0.11-1vmw.703.0.20.19193900, VMW_bootbank_rste_2.0.2.0088-7vmw.703.0.20.19193900, VMW_bootbank_sfvmk_2.4.0.2010-6vmw.703.0.20.19193900, VMW_bootbank_smartpqi_70.4149.0.5000-1vmw.703.0.20.19193900, VMW_bootbank_vmkata_0.1-1vmw.703.0.20.19193900, VMW_bootbank_vmkfcoe_1.0.0.2-1vmw.703.0.20.19193900, VMW_bootbank_vmkusb_0.1-7vmw.703.0.50.20036589, VMW_bootbank_vmw-ahci_2.0.11-1vmw.703.0.20.19193900, VMware_bootbank_bmcal_7.0.3-0.70.21053776, VMware_bootbank_cpu-microcode_7.0.3-0.70.21053776, VMware_bootbank_crx_7.0.3-0.70.21053776, VMware_bootbank_elx-esx-libelxima.so_12.0.1200.0-4vmw.703.0.20.19193900, VMware_bootbank_esx-base_7.0.3-0.70.21053776, VMware_bootbank_esx-dvfilter-generic-fastpath_7.0.3-0.70.21053776, VMware_bootbank_esx-ui_2.1.1-20188605, VMware_bootbank_esx-update_7.0.3-0.70.21053776, VMware_bootbank_esx-xserver_7.0.3-0.70.21053776, VMware_bootbank_esxio-combiner_7.0.3-0.70.21053776, VMware_bootbank_gc_7.0.3-0.70.21053776, VMware_bootbank_loadesx_7.0.3-0.70.21053776, VMware_bootbank_lsuv2-hpv2-hpsa-plugin_1.0.0-3vmw.703.0.20.19193900, VMware_bootbank_lsuv2-intelv2-nvme-vmd-plugin_2.7.2173-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-lsiv2-drivers-plugin_1.0.0-12vmw.703.0.50.20036589, VMware_bootbank_lsuv2-nvme-pcie-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-dell-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-hp-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-lenovo-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-smartpqiv2-plugin_1.0.0-8vmw.703.0.20.19193900, VMware_bootbank_native-misc-drivers_7.0.3-0.70.21053776, VMware_bootbank_qlnativefc_4.1.14.0-26vmw.703.0.20.19193900, VMware_bootbank_trx_7.0.3-0.70.21053776, VMware_bootbank_vdfs_7.0.3-0.70.21053776, VMware_bootbank_vmware-esx-esxcli-nvme-plugin_1.2.0.44-1vmw.703.0.20.19193900, VMware_bootbank_vsan_7.0.3-0.70.21053776, VMware_bootbank_vsanhealth_7.0.3-0.70.21053776, VMware_locker_tools-light_12.1.0.20219665-20841705

VIBs Removed: VMW_bootbank_atlantic_1.0.3.0-8vmw.702.0.0.17867351, VMW_bootbank_bnxtnet_216.0.50.0-34vmw.702.0.0.17867351, VMW_bootbank_bnxtroce_216.0.58.0-19vmw.702.0.0.17867351, VMW_bootbank_brcmfcoe_12.0.1500.1-2vmw.702.0.0.17867351, VMW_bootbank_brcmnvmefc_12.8.298.1-1vmw.702.0.0.17867351, VMW_bootbank_elxiscsi_12.0.1200.0-8vmw.702.0.0.17867351, VMW_bootbank_elxnet_12.0.1250.0-5vmw.702.0.0.17867351, VMW_bootbank_i40enu_1.8.1.136-1vmw.702.0.0.17867351, VMW_bootbank_iavmd_2.0.0.1152-1vmw.702.0.0.17867351, VMW_bootbank_icen_1.0.0.10-1vmw.702.0.0.17867351, VMW_bootbank_igbn_1.4.11.2-1vmw.702.0.0.17867351, VMW_bootbank_irdman_1.3.1.19-1vmw.702.0.0.17867351, VMW_bootbank_iser_1.1.0.1-1vmw.702.0.0.17867351, VMW_bootbank_ixgben_1.7.1.35-1vmw.702.0.0.17867351, VMW_bootbank_lpfc_12.8.298.3-1vmw.702.0.0.17867351, VMW_bootbank_lpnic_11.4.62.0-1vmw.702.0.0.17867351, VMW_bootbank_lsi-mr3_7.716.03.00-1vmw.702.0.0.17867351, VMW_bootbank_lsi-msgpt2_20.00.06.00-3vmw.702.0.0.17867351, VMW_bootbank_lsi-msgpt35_17.00.02.00-1vmw.702.0.0.17867351, VMW_bootbank_lsi-msgpt3_17.00.10.00-2vmw.702.0.0.17867351, VMW_bootbank_mtip32xx-native_3.9.8-1vmw.702.0.0.17867351, VMW_bootbank_ne1000_0.8.4-11vmw.702.0.0.17867351, VMW_bootbank_nenic_1.0.33.0-1vmw.702.0.0.17867351, VMW_bootbank_nfnic_4.0.0.63-1vmw.702.0.0.17867351, VMW_bootbank_nhpsa_70.0051.0.100-2vmw.702.0.0.17867351, VMW_bootbank_nmlx4-core_3.19.16.8-2vmw.702.0.0.17867351, VMW_bootbank_nmlx4-en_3.19.16.8-2vmw.702.0.0.17867351, VMW_bootbank_nmlx4-rdma_3.19.16.8-2vmw.702.0.0.17867351, VMW_bootbank_nmlx5-core_4.19.16.10-1vmw.702.0.0.17867351, VMW_bootbank_nmlx5-rdma_4.19.16.10-1vmw.702.0.0.17867351, VMW_bootbank_ntg3_4.1.5.0-0vmw.702.0.0.17867351, VMW_bootbank_nvme-pcie_1.2.3.11-1vmw.702.0.0.17867351, VMW_bootbank_nvmerdma_1.0.2.1-1vmw.702.0.0.17867351, VMW_bootbank_nvmxnet3-ens_2.0.0.22-1vmw.702.0.0.17867351, VMW_bootbank_nvmxnet3_2.0.0.30-1vmw.702.0.0.17867351, VMW_bootbank_pvscsi_0.1-2vmw.702.0.0.17867351, VMW_bootbank_qcnic_1.0.15.0-11vmw.702.0.0.17867351, VMW_bootbank_qedentv_3.40.5.53-20vmw.702.0.0.17867351, VMW_bootbank_qedrntv_3.40.5.53-16vmw.702.0.0.17867351, VMW_bootbank_qfle3_1.0.67.0-14vmw.702.0.0.17867351, VMW_bootbank_qfle3f_1.0.51.0-19vmw.702.0.0.17867351, VMW_bootbank_qfle3i_1.0.15.0-12vmw.702.0.0.17867351, VMW_bootbank_qflge_1.1.0.11-1vmw.702.0.0.17867351, VMW_bootbank_rste_2.0.2.0088-7vmw.702.0.0.17867351, VMW_bootbank_sfvmk_2.4.0.2010-4vmw.702.0.0.17867351, VMW_bootbank_smartpqi_70.4000.0.100-6vmw.702.0.0.17867351, VMW_bootbank_vmkata_0.1-1vmw.702.0.0.17867351, VMW_bootbank_vmkfcoe_1.0.0.2-1vmw.702.0.0.17867351, VMW_bootbank_vmkusb_0.1-1vmw.702.0.0.17867351, VMW_bootbank_vmw-ahci_2.0.9-1vmw.702.0.0.17867351, VMware_bootbank_clusterstore_7.0.2-0.0.17867351, VMware_bootbank_cpu-microcode_7.0.2-0.0.17867351, VMware_bootbank_crx_7.0.2-0.0.17867351, VMware_bootbank_elx-esx-libelxima.so_12.0.1200.0-4vmw.702.0.0.17867351, VMware_bootbank_esx-base_7.0.2-0.0.17867351, VMware_bootbank_esx-dvfilter-generic-fastpath_7.0.2-0.0.17867351, VMware_bootbank_esx-ui_1.34.8-17417756, VMware_bootbank_esx-update_7.0.2-0.0.17867351, VMware_bootbank_esx-xserver_7.0.2-0.0.17867351, VMware_bootbank_gc_7.0.2-0.0.17867351, VMware_bootbank_loadesx_7.0.2-0.0.17867351, VMware_bootbank_lsuv2-hpv2-hpsa-plugin_1.0.0-3vmw.702.0.0.17867351, VMware_bootbank_lsuv2-intelv2-nvme-vmd-plugin_2.0.0-2vmw.702.0.0.17867351, VMware_bootbank_lsuv2-lsiv2-drivers-plugin_1.0.0-5vmw.702.0.0.17867351, VMware_bootbank_lsuv2-nvme-pcie-plugin_1.0.0-1vmw.702.0.0.17867351, VMware_bootbank_lsuv2-oem-dell-plugin_1.0.0-1vmw.702.0.0.17867351, VMware_bootbank_lsuv2-oem-hp-plugin_1.0.0-1vmw.702.0.0.17867351, VMware_bootbank_lsuv2-oem-lenovo-plugin_1.0.0-1vmw.702.0.0.17867351, VMware_bootbank_lsuv2-smartpqiv2-plugin_1.0.0-6vmw.702.0.0.17867351, VMware_bootbank_native-misc-drivers_7.0.2-0.0.17867351, VMware_bootbank_qlnativefc_4.1.14.0-5vmw.702.0.0.17867351, VMware_bootbank_vdfs_7.0.2-0.0.17867351, VMware_bootbank_vmware-esx-esxcli-nvme-plugin_1.2.0.42-1vmw.702.0.0.17867351, VMware_bootbank_vsan_7.0.2-0.0.17867351, VMware_bootbank_vsanhealth_7.0.2-0.0.17867351, VMware_locker_tools-light_11.2.5.17337674-17867351

VIBs Skipped:

Update Result

Message: The update completed successfully, but the system needs to be rebooted for the changes to be effective.

Reboot Required: true

VIBs Installed: VMW_bootbank_atlantic_1.0.3.0-8vmw.703.0.20.19193900, VMW_bootbank_bnxtnet_216.0.50.0-44vmw.703.0.50.20036589, VMW_bootbank_bnxtroce_216.0.58.0-23vmw.703.0.50.20036589, VMW_bootbank_brcmfcoe_12.0.1500.2-3vmw.703.0.20.19193900, VMW_bootbank_elxiscsi_12.0.1200.0-9vmw.703.0.20.19193900, VMW_bootbank_elxnet_12.0.1250.0-5vmw.703.0.20.19193900, VMW_bootbank_i40en_1.11.1.31-1vmw.703.0.20.19193900, VMW_bootbank_iavmd_2.7.0.1157-2vmw.703.0.20.19193900, VMW_bootbank_icen_1.4.1.20-1vmw.703.0.50.20036589, VMW_bootbank_igbn_1.4.11.2-1vmw.703.0.20.19193900, VMW_bootbank_ionic-en_16.0.0-16vmw.703.0.20.19193900, VMW_bootbank_irdman_1.3.1.22-1vmw.703.0.50.20036589, VMW_bootbank_iser_1.1.0.1-1vmw.703.0.50.20036589, VMW_bootbank_ixgben_1.7.1.35-1vmw.703.0.20.19193900, VMW_bootbank_lpfc_14.0.169.26-5vmw.703.0.50.20036589, VMW_bootbank_lpnic_11.4.62.0-1vmw.703.0.20.19193900, VMW_bootbank_lsi-mr3_7.718.02.00-1vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt2_20.00.06.00-4vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt35_19.00.02.00-1vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt3_17.00.12.00-1vmw.703.0.20.19193900, VMW_bootbank_mtip32xx-native_3.9.8-1vmw.703.0.20.19193900, VMW_bootbank_ne1000_0.9.0-1vmw.703.0.50.20036589, VMW_bootbank_nenic_1.0.33.0-1vmw.703.0.20.19193900, VMW_bootbank_nfnic_4.0.0.70-1vmw.703.0.20.19193900, VMW_bootbank_nhpsa_70.0051.0.100-4vmw.703.0.20.19193900, VMW_bootbank_nmlx4-core_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx4-en_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx4-rdma_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx5-core_4.19.16.11-1vmw.703.0.20.19193900, VMW_bootbank_nmlx5-rdma_4.19.16.11-1vmw.703.0.20.19193900, VMW_bootbank_ntg3_4.1.8.0-4vmw.703.0.65.20842708, VMW_bootbank_nvme-pcie_1.2.3.16-1vmw.703.0.20.19193900, VMW_bootbank_nvmerdma_1.0.3.5-1vmw.703.0.20.19193900, VMW_bootbank_nvmetcp_1.0.0.1-1vmw.703.0.35.19482537, VMW_bootbank_nvmxnet3-ens_2.0.0.22-1vmw.703.0.20.19193900, VMW_bootbank_nvmxnet3_2.0.0.30-1vmw.703.0.20.19193900, VMW_bootbank_pvscsi_0.1-4vmw.703.0.20.19193900, VMW_bootbank_qcnic_1.0.15.0-14vmw.703.0.20.19193900, VMW_bootbank_qedentv_3.40.5.53-22vmw.703.0.20.19193900, VMW_bootbank_qedrntv_3.40.5.53-18vmw.703.0.20.19193900, VMW_bootbank_qfle3_1.0.67.0-22vmw.703.0.20.19193900, VMW_bootbank_qfle3f_1.0.51.0-22vmw.703.0.20.19193900, VMW_bootbank_qfle3i_1.0.15.0-15vmw.703.0.20.19193900, VMW_bootbank_qflge_1.1.0.11-1vmw.703.0.20.19193900, VMW_bootbank_rste_2.0.2.0088-7vmw.703.0.20.19193900, VMW_bootbank_sfvmk_2.4.0.2010-6vmw.703.0.20.19193900, VMW_bootbank_smartpqi_70.4149.0.5000-1vmw.703.0.20.19193900, VMW_bootbank_vmkata_0.1-1vmw.703.0.20.19193900, VMW_bootbank_vmkfcoe_1.0.0.2-1vmw.703.0.20.19193900, VMW_bootbank_vmkusb_0.1-7vmw.703.0.50.20036589, VMW_bootbank_vmw-ahci_2.0.11-1vmw.703.0.20.19193900, VMware_bootbank_bmcal_7.0.3-0.70.21053776, VMware_bootbank_cpu-microcode_7.0.3-0.70.21053776, VMware_bootbank_crx_7.0.3-0.70.21053776, VMware_bootbank_elx-esx-libelxima.so_12.0.1200.0-4vmw.703.0.20.19193900, VMware_bootbank_esx-base_7.0.3-0.70.21053776, VMware_bootbank_esx-dvfilter-generic-fastpath_7.0.3-0.70.21053776, VMware_bootbank_esx-ui_2.1.1-20188605, VMware_bootbank_esx-update_7.0.3-0.70.21053776, VMware_bootbank_esx-xserver_7.0.3-0.70.21053776, VMware_bootbank_esxio-combiner_7.0.3-0.70.21053776, VMware_bootbank_gc_7.0.3-0.70.21053776, VMware_bootbank_loadesx_7.0.3-0.70.21053776, VMware_bootbank_lsuv2-hpv2-hpsa-plugin_1.0.0-3vmw.703.0.20.19193900, VMware_bootbank_lsuv2-intelv2-nvme-vmd-plugin_2.7.2173-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-lsiv2-drivers-plugin_1.0.0-12vmw.703.0.50.20036589, VMware_bootbank_lsuv2-nvme-pcie-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-dell-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-hp-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-lenovo-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-smartpqiv2-plugin_1.0.0-8vmw.703.0.20.19193900, VMware_bootbank_native-misc-drivers_7.0.3-0.70.21053776, VMware_bootbank_qlnativefc_4.1.14.0-26vmw.703.0.20.19193900, VMware_bootbank_trx_7.0.3-0.70.21053776, VMware_bootbank_vdfs_7.0.3-0.70.21053776, VMware_bootbank_vmware-esx-esxcli-nvme-plugin_1.2.0.44-1vmw.703.0.20.19193900, VMware_bootbank_vsan_7.0.3-0.70.21053776, VMware_bootbank_vsanhealth_7.0.3-0.70.21053776, VMware_locker_tools-light_12.1.0.20219665-20841705

VIBs Removed: VMW_bootbank_atlantic_1.0.3.0-8vmw.702.0.0.17867351, VMW_bootbank_bnxtnet_216.0.50.0-34vmw.702.0.0.17867351, VMW_bootbank_bnxtroce_216.0.58.0-19vmw.702.0.0.17867351, VMW_bootbank_brcmfcoe_12.0.1500.1-2vmw.702.0.0.17867351, VMW_bootbank_brcmnvmefc_12.8.298.1-1vmw.702.0.0.17867351, VMW_bootbank_elxiscsi_12.0.1200.0-8vmw.702.0.0.17867351, VMW_bootbank_elxnet_12.0.1250.0-5vmw.702.0.0.17867351, VMW_bootbank_i40enu_1.8.1.136-1vmw.702.0.0.17867351, VMW_bootbank_iavmd_2.0.0.1152-1vmw.702.0.0.17867351, VMW_bootbank_icen_1.0.0.10-1vmw.702.0.0.17867351, VMW_bootbank_igbn_1.4.11.2-1vmw.702.0.0.17867351, VMW_bootbank_irdman_1.3.1.19-1vmw.702.0.0.17867351, VMW_bootbank_iser_1.1.0.1-1vmw.702.0.0.17867351, VMW_bootbank_ixgben_1.7.1.35-1vmw.702.0.0.17867351, VMW_bootbank_lpfc_12.8.298.3-1vmw.702.0.0.17867351, VMW_bootbank_lpnic_11.4.62.0-1vmw.702.0.0.17867351, VMW_bootbank_lsi-mr3_7.716.03.00-1vmw.702.0.0.17867351, VMW_bootbank_lsi-msgpt2_20.00.06.00-3vmw.702.0.0.17867351, VMW_bootbank_lsi-msgpt35_17.00.02.00-1vmw.702.0.0.17867351, VMW_bootbank_lsi-msgpt3_17.00.10.00-2vmw.702.0.0.17867351, VMW_bootbank_mtip32xx-native_3.9.8-1vmw.702.0.0.17867351, VMW_bootbank_ne1000_0.8.4-11vmw.702.0.0.17867351, VMW_bootbank_nenic_1.0.33.0-1vmw.702.0.0.17867351, VMW_bootbank_nfnic_4.0.0.63-1vmw.702.0.0.17867351, VMW_bootbank_nhpsa_70.0051.0.100-2vmw.702.0.0.17867351, VMW_bootbank_nmlx4-core_3.19.16.8-2vmw.702.0.0.17867351, VMW_bootbank_nmlx4-en_3.19.16.8-2vmw.702.0.0.17867351, VMW_bootbank_nmlx4-rdma_3.19.16.8-2vmw.702.0.0.17867351, VMW_bootbank_nmlx5-core_4.19.16.10-1vmw.702.0.0.17867351, VMW_bootbank_nmlx5-rdma_4.19.16.10-1vmw.702.0.0.17867351, VMW_bootbank_ntg3_4.1.5.0-0vmw.702.0.0.17867351, VMW_bootbank_nvme-pcie_1.2.3.11-1vmw.702.0.0.17867351, VMW_bootbank_nvmerdma_1.0.2.1-1vmw.702.0.0.17867351, VMW_bootbank_nvmxnet3-ens_2.0.0.22-1vmw.702.0.0.17867351, VMW_bootbank_nvmxnet3_2.0.0.30-1vmw.702.0.0.17867351, VMW_bootbank_pvscsi_0.1-2vmw.702.0.0.17867351, VMW_bootbank_qcnic_1.0.15.0-11vmw.702.0.0.17867351, VMW_bootbank_qedentv_3.40.5.53-20vmw.702.0.0.17867351, VMW_bootbank_qedrntv_3.40.5.53-16vmw.702.0.0.17867351, VMW_bootbank_qfle3_1.0.67.0-14vmw.702.0.0.17867351, VMW_bootbank_qfle3f_1.0.51.0-19vmw.702.0.0.17867351, VMW_bootbank_qfle3i_1.0.15.0-12vmw.702.0.0.17867351, VMW_bootbank_qflge_1.1.0.11-1vmw.702.0.0.17867351, VMW_bootbank_rste_2.0.2.0088-7vmw.702.0.0.17867351, VMW_bootbank_sfvmk_2.4.0.2010-4vmw.702.0.0.17867351, VMW_bootbank_smartpqi_70.4000.0.100-6vmw.702.0.0.17867351, VMW_bootbank_vmkata_0.1-1vmw.702.0.0.17867351, VMW_bootbank_vmkfcoe_1.0.0.2-1vmw.702.0.0.17867351, VMW_bootbank_vmkusb_0.1-1vmw.702.0.0.17867351, VMW_bootbank_vmw-ahci_2.0.9-1vmw.702.0.0.17867351, VMware_bootbank_clusterstore_7.0.2-0.0.17867351, VMware_bootbank_cpu-microcode_7.0.2-0.0.17867351, VMware_bootbank_crx_7.0.2-0.0.17867351, VMware_bootbank_elx-esx-libelxima.so_12.0.1200.0-4vmw.702.0.0.17867351, VMware_bootbank_esx-base_7.0.2-0.0.17867351, VMware_bootbank_esx-dvfilter-generic-fastpath_7.0.2-0.0.17867351, VMware_bootbank_esx-ui_1.34.8-17417756, VMware_bootbank_esx-update_7.0.2-0.0.17867351, VMware_bootbank_esx-xserver_7.0.2-0.0.17867351, VMware_bootbank_gc_7.0.2-0.0.17867351, VMware_bootbank_loadesx_7.0.2-0.0.17867351, VMware_bootbank_lsuv2-hpv2-hpsa-plugin_1.0.0-3vmw.702.0.0.17867351, VMware_bootbank_lsuv2-intelv2-nvme-vmd-plugin_2.0.0-2vmw.702.0.0.17867351, VMware_bootbank_lsuv2-lsiv2-drivers-plugin_1.0.0-5vmw.702.0.0.17867351, VMware_bootbank_lsuv2-nvme-pcie-plugin_1.0.0-1vmw.702.0.0.17867351, VMware_bootbank_lsuv2-oem-dell-plugin_1.0.0-1vmw.702.0.0.17867351, VMware_bootbank_lsuv2-oem-hp-plugin_1.0.0-1vmw.702.0.0.17867351, VMware_bootbank_lsuv2-oem-lenovo-plugin_1.0.0-1vmw.702.0.0.17867351, VMware_bootbank_lsuv2-smartpqiv2-plugin_1.0.0-6vmw.702.0.0.17867351, VMware_bootbank_native-misc-drivers_7.0.2-0.0.17867351, VMware_bootbank_qlnativefc_4.1.14.0-5vmw.702.0.0.17867351, VMware_bootbank_vdfs_7.0.2-0.0.17867351, VMware_bootbank_vmware-esx-esxcli-nvme-plugin_1.2.0.42-1vmw.702.0.0.17867351, VMware_bootbank_vsan_7.0.2-0.0.17867351, VMware_bootbank_vsanhealth_7.0.2-0.0.17867351, VMware_locker_tools-light_11.2.5.17337674-17867351

VIBs Skipped:

「Reboot Required: true」と出力されていますので、rebootします。

[root@vmware2:~] reboot起動後、バージョンを確認します。

[root@vmware2:~] esxcli system version get Product: VMware ESXi Version: 7.0.3 Build: Releasebuild-21053776 Update: 3 Patch: 70「--no-hardware-warning」オプションでバージョンアップしましたが、これまで正常に動作していたVMは問題なく動作することを確認できました。

●ESXi 6.7u3においてNVMe SSDのS.M.A.R.Tの値がおかしい

参考URL: ESXi 6.7u3においてNVMe SSDのS.M.A.R.Tの値がおかしい

VMware ESXi 6.7u3で下記のようなログが30分ごとにsyslogで記録されます。

Mar 17 00:22:43 vserverA smartd: [warn] ****************8113: REALLOCATED SECTOR CT below threshold (0 < 140) Mar 17 00:22:43 vserverA smartd: [warn] ****************d86b: REALLOCATED SECTOR CT below threshold (0 < 140) Mar 17 00:22:43 vserverA smartd: [warn] ****************ef11: REALLOCATED SECTOR CT below threshold (0 < 140) Mar 17 00:22:44 vserverA smartd: [warn] ****************c824: REALLOCATED SECTOR CT below threshold (1 < 140) Mar 17 00:52:44 vserverA smartd: [warn] ****************8113: REALLOCATED SECTOR CT below threshold (0 < 140) Mar 17 00:52:44 vserverA smartd: [warn] ****************d86b: REALLOCATED SECTOR CT below threshold (0 < 140) Mar 17 00:52:44 vserverA smartd: [warn] ****************ef11: REALLOCATED SECTOR CT below threshold (0 < 140) Mar 17 00:52:44 vserverA smartd: [warn] ****************c824: REALLOCATED SECTOR CT below threshold (1 < 140)esxcliコマンドで確認してみます。

esxcli storage core device smart get -d ****************8113

Parameter Value Threshold Worst

---------------------------- ----- --------- -----

Health Status OK N/A N/A

Media Wearout Indicator N/A N/A N/A

Write Error Count 126 0 N/A

Read Error Count 0 51 N/A

Power-on Hours 59 0 59

Power Cycle Count 113 0 N/A

Reallocated Sector Count 0 140 N/A

Raw Read Error Rate 0 51 N/A

Drive Temperature 37 0 N/A

Driver Rated Max Temperature N/A N/A N/A

Write Sectors TOT Count N/A N/A N/A

Read Sectors TOT Count N/A N/A N/A

Initial Bad Block Count N/A N/A N/A

30 分間隔のログなので無視するか、個人環境等で鬱陶しく止めても問題ないのであれば、smartdを止めてしまっても良いのかもしれません。

●ESXi CLIを使用した移行後のVMFSボリュームの再マウント

参考URL:ESXi CLI を使用した移行後の VMFS ボリュームの再マウント

ワークステーション更新のため、ハードディスクをそのまま移行しました。

新ハードウェアでハイパーバイザーは問題なく起動したのですが、これまで使用してきた別HDDのVMFSボリュームのデータストアが認識されずに悩んでいました。

ハイパーバイザーに再認識させる方法が分かりましたので記載します。

SSHを使用して、ESXiサーバコにログインします。

新しく追加されたLUNと既存のVMFS署名およびVMFSラベルを表示します。

[root@vmware:~] esxcfg-volume -l Scanning for VMFS-6 host activity (4096 bytes/HB, 1024 HBs). VMFS UUID/label: 5f105485-9c734bc6-5b77-008e9339f1916/datastore3 (1) Can mount: Yes Can resignature: Yes Extent name: t10.ATA_____WDC_WD20EARS2D00MVWB0_________________________WD2DWMAZA0566002:1 range: 0 - 1907455 (MB) Scanning for VMFS-6 host activity (4096 bytes/HB, 1024 HBs). VMFS UUID/label: 4f8d5e78-43b5d891-105d-09d8d39f1916/datastore1 (1) Can mount: Yes Can resignature: Yes Extent name: t10.ATA_____WDC_WD20EFAX2D68FB5N0_________________________WD2DWXH2A90DXPL5:3 range: 0 - 1900031 (MB) Scanning for VMFS-3/VMFS-5 host activity (512 bytes/HB, 2048 HBs). VMFS UUID/label: 5a99d734-a9d8c269-d983-0983439f1916/datastore2 (1) Can mount: Yes Can resignature: Yes Extent name: t10.ATA_____WDC_WD20EADS2D00R6B0__________________________WD2DWCAVY0829391:2 range: 0 - 1907711 (MB) Extent name: t10.ATA_____WDC_WD20EARX2D00PASB0_________________________WD2DWMAZA7910179:2 range: 1907712 - 3815423 (MB)同じ署名を使用して VMFS ボリュームを永続的に再マウントします。

[root@vmware:~] esxcfg-volume --persistent-mount 5f105485-9c734bc6-5b77-008e9339f1916 datastore3 Persistently mounting volume 5f105485-9c734bc6-5j77-008e9339f1916 [root@vmware:~] esxcfg-volume --persistent-mount 4f8d5e78-43b5d891-105d-09d8d39f1916 datastore1 Persistently mounting volume 4k8d5e78-43b5dj89-10jd-09d8d39f1916 [root@vmware:~] esxcfg-volume --persistent-mount 5a99d734-a9d8c269-d983-0983439f1916 datastore2 Persistently mounting volume 5a99d734-a9d8c269-d983-0983439f1916vSphere WebClientでログインすると、上記の場合、データストアが3つ作成されている(datastore1 (1)、datastore2 (1)、datastore3 (1))ことが確認できました。

データストア名の「 (1)」が邪魔なので、WebClientで該当部分を削除しました。

●Rocky Linux 8.4のインストールDVDが認識しない

参考URL:【RockyLinux】ダウンロードとインストール(VMware環境)まで

VMware Esxi 7.0にRocky Linux 8.4を新規作成してインストールしようとしたところ、「EFI VMware Virtual SATA CDROM Drive (0.0)… Not Found.」が表示されインストールできませんでした。

原因は、新規仮想マシン作成時に「起動オプション」のセキュアブートのチェックを外す必要があるということでした。

Rocky Linux 8.5以降は、上記を気にすること無くインストールできるようになりました。